目录

3、第二阶段续篇

13、Tomcat集群部署

1、介绍

bashTomcat Tomcat和Nginx类似,都是WEB服务器软件 只不过Tomcat是基于JAVA开发的WEB服务,主要解析JAVA代码 Nginx仅支持静态资源解析,而Tomcat支持解析Java开发的WEB应用,还支持解析静态资源(效率不高) Nginx适合做前端负载均衡,Tomcat适合做后端应用服务处理 通常情况企业会使用Nginx+Tomcat结合,Nginx处理静态资源,Tomcat处理动态资源 JAVA环境JRE和JDK的区别 jre是java的运行环境,包含jvm jdk是java的开发环境,会包含java的运行环境jre 如果说单纯的运行java代码,只需要jre足够,但如果需要提供开发环境以及运行环境则需要JDK

2、Tomcat快速安装

1、安装jdk

bash1、上传rmp包

2、解压

[root@web01 ~]#rpm -ivh jdk-8u181-linux-x64.rpm

查看是否安装成功

[root@web01 ~]#rpm -qa|grep jdk

jdk1.8-1.8.0_181-fcs.x86_64

2、安装Tomcat

bash1、安装Tomcat(下载 Tomcat、解压、启动 )

Tomcat官网: https://tomcat.apache.org

[root@web01 ~]#wget https://dlcdn.apache.org/tomcat/tomcat-9/v9.0.104/bin/apache-tomcat-9.0.104.tar.gz

2、创建Tomcat目录/soft

[root@web01 ~]#mkdir /soft

3、解压

[root@web01 ~]#tar xf apache-tomcat-9.0.104.tar.gz -C /soft/

4、创建软连接

[root@web01 ~]#ln -s /soft/apache-tomcat-9.0.104/ /soft/tomcat

5、启动

[root@web01 ~]# /soft/tomcat/bin/startup.sh

Using CATALINA_BASE: /soft/apache

Using CATALINA_HOME: /soft/apache

Using CATALINA_TMPDIR: /soft/apache/temp

Using JRE_HOME: /usr

Using CLASSPATH: /soft/apache/bin/bootstrap.jar:/soft/apache/bin/tomcat-juli.jar

Using CATALINA_OPTS:

Tomcat started.

[root@web01 /soft]#netstat -tnulp

# 8080 对外提供服务的端口 # 8005 关闭Tomcat端口

Active Internet connections (only servers)

tcp6 0 0 127.0.0.1:8005 :::* LISTEN 3171/java

tcp6 0 0 :::8080 :::* LISTEN 3171/java

6、停止

[root@web01 ~]# /soft/tomcat/bin/shutdown.sh

3、配置systemc方式启动

bash#1.查看内容

[root@lb01 ~]# systemctl cat nginx

#2.不存在文件则自动创建,并复制进去

[root@lb01 ~]# cat >/usr/lib/systemd/system/tomcat.service<<'EOF'

[Unit]

Description=Apache Tomcat Server

After=network.target remote-fs.target nss-lookup.target

[Service]

Type=forking

ExecStart=/soft/tomcat/bin/startup.sh

ExecStop=/soft/tomcat/bin/shutdown.sh

ExecRetart=/soft/tomcat/bin/shutdown.sh && sleep2 && /soft/tomcat/bin/startup.sh

[Install]

WantedBy=multi-user.target

EOF

#3.查看内容

[root@web01 /soft]#cat /usr/lib/systemd/system/tomcat.service

[Unit]

Description=Apache Tomcat Server

After=network.target remote-fs.target nss-lookup.target

[Service]

Type=forking

ExecStart=/soft/tomcat/bin/startup.sh #启动的命令

ExecStop=/soft/tomcat/bin/shutdown.sh #停止的命令

ExecRetart=/soft/tomcat/bin/shutdown.sh && sleep2 && /soft/tomcat/bin/startup.sh

[Install]

WantedBy=multi-user.target

#4.重新加载

[root@web01 /soft]#systemctl daemon-reload

[root@web01 /soft]#systemctl enable tomcat

Created symlink /etc/systemd/system/multi-user.target.wants/tomcat.service → /usr/lib/systemd/system/tomcat.service.

#5.启动tomcat

[root@web01 /soft]#systemctl start tomcat

[root@web01 /soft]#netstat -tnulp

Active Internet connections (only servers)

Proto Recv-Q Send-Q Local Address Foreign Address State PID/Program name

tcp6 0 0 127.0.0.1:8005 :::* LISTEN 3491/java

tcp6 0 0 :::8080 :::* LISTEN 3491/java

4、配置文件

bashtomcat软件目录结构:/soft/tomcat

bin ---主要包含启动和关闭tomcat的脚本(启停java脚本依赖jar包文件)

conf ---tomcat配置文件的目录(站点配置:server.xml)

lib ---tomcat运行时需要加载的jar包

logs ---tomcat日志存放位置

temp ---tomcat临时存放文件路径

webapps ---tomcat默认站点目录

work ---tomcat运行时产生的缓存文件

配置文件详解-----> /soft/tomcat/conf/server.xml

<?xml version="1.0" encoding="UTF-8"?>

<Server port="8005" shutdown="SHUTDOWN"> #关闭通过8005端口关闭

<Listener className="org.apache.catalina.startup.VersionLoggerListener" />

<Listener className="org.apache.catalina.core.AprLifecycleListener" />

<Listener className="org.apache.catalina.core.JreMemoryLeakPreventionListener" />

<Listener className="org.apache.catalina.mbeans.GlobalResourcesLifecycleListener" />

<Listener className="org.apache.catalina.core.ThreadLocalLeakPreventionListener" />

<GlobalNamingResources>

<Resource name="UserDatabase" auth="Container"

type="org.apache.catalina.UserDatabase"

description="User database that can be updated and saved"

factory="org.apache.catalina.users.MemoryUserDatabaseFactory"

pathname="conf/tomcat-users.xml" />

</GlobalNamingResources>

<Service name="Catalina"> #主服务

<Connector port="8080" protocol="HTTP/1.1" #连接器,响应外部用户的连接请求。可以有多个sever,也就是多个域名

connectionTimeout="20000"

redirectPort="8443"

maxParameterCount="1000"

/>

<Engine name="Catalina" defaultHost="localhost"> #引擎,类似于容器

<Realm className="org.apache.catalina.realm.LockOutRealm">

<Realm className="org.apache.catalina.realm.UserDatabaseRealm"

resourceName="UserDatabase"/>

</Realm>

<Host name="localhost" appBase="webapps"

unpackWARs="true" autoDeploy="true">

<Valve className="org.apache.catalina.valves.AccessLogValve" directory="logs"

prefix="localhost_access_log" suffix=".txt"

pattern="%h %l %u %t "%r" %s %b" />

</Host>

--------------------------------------配置虚拟主机------------------------------------------------------------

<Host name="diy.etiantian.ora" appBase="/code/diy" #域名、代码目录,默认是webapps/ROOT,比nginx多这一级

unpackWARs="true" autoDeploy="true"> #自动解压WAR包,类似于zip,但不需要手动解压

<Valve className="org.apache.catalina.valves.AccessLogValve" directory="logs" #日志

prefix="diy_access_log" suffix=".txt" #日志名称、后缀

pattern="%h %l %u %t "%r" %s %b" /> #自定义日志格式

--------------------------------------配置虚拟主机-----------------------------------------------------------

</Host>

</Engine>

</Service>

</Server>

# </Connector>连接器包含着 <Engine引擎,引擎里面包含着<Host,可以包含多个<Host

bash#1.添加域名

<Host name="diy.etiantian.ora" appBase="/code/diy"

unpackWARs="true" autoDeploy="true">

<Valve className="org.apache.catalina.valves.AccessLogValve" directory="logs"

prefix="diy_access_log" suffix=".txt"

pattern="%h %l %u %t "%r" %s %b" />

</Host>

[root@web01 /soft/tomcat/conf]#mkdir /code/diy

[root@web01 /soft/tomcat/conf]#echo tomcat ... > /code/diy/index.html

[root@web01 /soft/tomcat/conf]#systemctl restart tomcat

#2.如果配置文件有问题起不来端口,比如目录没创建,代码错误

[root@web01 /soft/tomcat/conf]#netstat -tnulp

tcp6 0 0 127.0.0.1:8005 :::* LISTEN 3914/java

tcp6 0 0 :::8080 :::* LISTEN 3914/java

# 日志文件

[root@web01 /soft/tomcat/conf]#cat /soft/tomcat/logs/catalina.out

#3.解析host 浏览器访问diy.etiantian.org:8080

bash#4.访问测试失败,因为没有创建ROOT目录

#5.创建ROOT目录

[root@web01 /soft/tomcat/conf]#mkdir /code/diy/ROOT -p

#6.将文件移动到ROOT下

[root@web01 /code/diy]#mv index.html ROOT/

#7.刷新测试

5、Tomcat Http请求过程

bash首先http或者https请求负载均衡,然后到server层,这里面有connector连接器,通过这个连接器响应我们客户端的连接,再通过service再转发

给引擎,引擎里面有多个host,看外部是哪个域名访问,通过引擎给用户响应host

简述Tomcat一个请求的完整过程?

Tomcat 处理一个请求的完整过程如下:

客户端请求:客户端(如浏览器)通过 HTTP 协议向 Tomcat 发送请求。

接收请求:Tomcat 的连接器(Connector)监听特定端口(如 8080),接收客户端的请求。

解析请求:连接器将请求封装成 HttpServletRequest 对象,并交给合适的引擎(Engine)。

匹配虚拟主机(Host):引擎(Engine)根据请求的主机名匹配到相应的 Host。

匹配上下文(Context):Host 进一步根据 URL 的路径部分将请求分发给相应的 Context(即对应的 web 应用)。

匹配过滤器(Filter):Context 根据请求路径匹配一系列的 Filter,按照顺序依次调用这些过滤器。

调用Servlet:过滤器处理完成后,将请求交给具体的 Servlet,由 Servlet 执行业务逻辑。

生成响应:Servlet 处理请求后,将响应数据写入 HttpServletResponse 对象中。

过滤器后处理:响应返回给过滤器链,过滤器可对响应进行后处理。

返回响应:Tomcat 将 HttpServletResponse 返回给连接器,由连接器通过网络将响应发送回客户端。

#tomcat中Context的作用:

<Host name="diy.etiantian.com" appBase="/code/diy"

unpackWARs="true" autoDeploy="true">

<!--访问diy.etiantian.com:8080/tt这个uri,获取/code/tt中页面资源,不存在该目录会报错 无法启动Tomcat 需要提前创建-->

<Context docBase="/code/tt" path="/tt" reloadable="true" />

<Valve className="org.apache.catalina.valves.AccessLogValve" directory="logs"

prefix="diy_access_log" suffix=".log"

pattern="%h %l %u %t "%r" %s %b" />

</Host>

#context作用:----> 类似于nginx中的alias,如果有人访问diy.etiantian.com:8080/tt,那么直接去/code/tt去获取资源,用context

#是不需要ROOT目录的

#Context测试

#1.增加配置文件

[root@web01 /soft/tomcat/conf]#vim server.xml

<Host name="diy.etiantian.org" appBase="/code/diy"

unpackWARs="true" autoDeploy="true">

<Context docBase="/code/tt" path="/tt" reloadable="true" /> #加了这行启动失败......

<Valve className="org.apache.catalina.valves.AccessLogValve" directory="logs"

prefix="diy_access_log" suffix=".txt"

pattern="%h %l %u %t "%r" %s %b" />

</Host>

#2.重启,启动失败

[root@web01 /soft/tomcat/conf]#systemctl restart tomcat

[root@web01 /soft/tomcat/conf]#netstat -tnulp

Active Internet connections (only servers)

Proto Recv-Q Send-Q Local Address Foreign Address State PID/Program name

tcp 0 0 0.0.0.0:22 0.0.0.0:* LISTEN 1081/sshd: /usr/sbi

tcp 0 0 127.0.0.1:9000 0.0.0.0:* LISTEN 1078/php-fpm: maste

tcp6 0 0 :::22 :::* LISTEN 1081/sshd: /usr/sbi

#3.查看报错日志,因为文件不存在导致无法读取

[root@web01 /soft/tomcat/conf]#cat ../logs/catalina.out

Caused by: java.lang.IllegalArgumentException: The main resource set specified [/code/tt] is not a directory or

war file, or is not readable (it does not exist or permissions to access it are missing)

#4.根据报错创建目录并写入测试数据

[root@web01 /soft/tomcat/conf]# mkdir /code/tt

[root@web01 /soft/tomcat/conf]#echo "tt...." > /code/tt/index.html

[root@web01 /soft/tomcat/conf]#cat /code/tt/index.html

tt....

#5.启动服务

[root@web01 /soft/tomcat/conf]#systemctl restart tomcat

[root@web01 /soft/tomcat/conf]#netstat -tnulp

Active Internet connections (only servers)

Proto Recv-Q Send-Q Local Address Foreign Address State PID/Program name

tcp 0 0 0.0.0.0:22 0.0.0.0:* LISTEN 1081/sshd: /usr/sbi

tcp 0 0 127.0.0.1:9000 0.0.0.0:* LISTEN 1078/php-fpm: maste

tcp6 0 0 :::22 :::* LISTEN 1081/sshd: /usr/sbi

tcp6 0 0 127.0.0.1:8005 :::* LISTEN 4818/java

tcp6 0 0 :::8080 :::* LISTEN 4818/java

#6.再次请求测试,diy.etiantian.org:8080/tt,默认访问index.html,如果是1.log那么路径是diy.etiantian.org:8080/tt/1.log

6、Tomcat管理页面

bashTomcat自带的管理页面:

管理功能

监控功能

1.所有的管理页面,都将权限赋予给了角色,而角色的名称是固定的:manager-gui admin-gui

2.需要添加一个用户,将用户捆绑至对应的角色,这样用户就可以访问到对应的页面

#编辑tomcat-users.xml文件将tomcat这个用户成为managergui,admin-gui这两个角色,就可以访问页面

[root@web01 /soft/tomcat/conf]#tail -5 tomcat-users.xml

-->

<role rolename="manager-gui"/>

<role rolename="admin-gui"/>

<user username="tomcat" password="123456" roles="manager-gui,admin-gui"/>

</tomcat-users>

3.由于项目默认允许127.0.0.1访问,所以配置好了角色和用户也无法正常访问:

#编辑配置文件

[root@web01 /soft/tomcat/conf]#vim /soft/tomcat/webapps/host-manager/META-INF/context.xml

将

allow="127\.\d+\.\d+\.\d+|::1|0:0:0:0:0:0:0:1" />

改为

allow="\d+\.\d+\.\d+\.\d+|::1|0:0:0:0:0:0:0:1" />

[root@web01 /soft/tomcat/conf]#vim /soft/tomcat/webapps/manager/META-INF/context.xml

将

allow="127\.\d+\.\d+\.\d+|::1|0:0:0:0:0:0:0:1" />

改为

allow="\d+\.\d+\.\d+\.\d+|::1|0:0:0:0:0:0:0:1" />

4. 重启tomcat并访问

[root@web01 /soft/tomcat/conf]#systemctl restart tomcat

[root@web01 /soft/tomcat/conf]#netstat -tnulp

Active Internet connections (only servers)

#浏览器访问测试

bash#编辑context路径

bash#添加模拟主机

bash本地host解析

#浏览器访问测试

7、Tomcat部署zrlog项目

bash#1.编辑配置文件

[root@web01]#vim /soft/tomcat/conf/server.xml

<Host name="zrlog.oldboy.com" appBase="/zrlog"

unpackWARs="true" autoDeploy="true">

<Valve className="org.apache.catalina.valves.AccessLogValve" directory="logs"

prefix="zrlog_access_log" suffix=".log"

pattern="%h %l %u %t "%r" %s %b" />

</Host>

#2.重启

[root@web01 /zrlog]#systemctl restart tomcat

[root@web01 /zrlog]#netstat -tnulp

Active Internet connections (only servers)

Proto Recv-Q Send-Q Local Address Foreign Address State PID/Program name

tcp 0 0 0.0.0.0:22 0.0.0.0:* LISTEN 1081/sshd: /usr/sbi

tcp 0 0 127.0.0.1:9000 0.0.0.0:* LISTEN 1078/php-fpm: maste

tcp6 0 0 :::22 :::* LISTEN 1081/sshd: /usr/sbi

tcp6 0 0 127.0.0.1:8005 :::* LISTEN 5377/java

tcp6 0 0 :::8080 :::* LISTEN 5377/java

#3.创建目录

[root@web01 /soft/tomcat/conf]#mkdir /zrlog

#4.上传war包,自动解压

[root@web01 /zrlog]#ll

total 15360

drwxr-x--- 9 root root 126 Apr 22 19:53 zrlog-2.2.1-efbe9f9-release

-rw-r--r-- 1 root root 11243048 Apr 21 17:03 zrlog-2.2.1-efbe9f9-release.war

#5.但是目录不对,修改名称为ROOT,自动解压,注意要大写

[root@web01 /zrlog]#mv zrlog-2.2.1-efbe9f9-release.war ROOT.war

[root@web01 /zrlog]#ll

total 15360

drwxr-x--- 9 root root 126 Apr 22 19:55 ROOT

-rw-r--r-- 1 root root 11243048 Apr 21 17:03 ROOT.war

#6.WINDOWS的hosts解析

10.0.0.7 zrlog.oldboy.com

#浏览器访问:zrlog.oldboy.com:8080

bash#7.数据库创建信息:

MariaDB [(none)]> create database zrlog;

Query OK, 1 row affected (0.022 sec)

MariaDB [(none)]> show databases;

+--------------------+

| Database |

+--------------------+

| information_schema |

| mysql |

| performance_schema |

| wordpress |

| zrlog |

+--------------------+

5 rows in set (0.296 sec)

#8.返回浏览器继续操作

3、Tomcat集群实战

bash1.在web02搭建Tomcat,把数据代码同步过去,默认连接数据库。 2.在web服务器前面加上负载均衡,转发两个接口,并且都以80端口去访问。 3.用户在访问web的时候实际是访问nginx的80端口,但是负载均衡是代理着用户去访问8080端口,与web分别建立连接。 4.找到两台web服务器图片存放的位置,部署nfs挂载到web服务器存放图片的路径

1、安装Tomcat

bash[root@oldboy ~]#yum install java -y # 默认安装的版本高 先不使用

#先通过上传rpm包的方式安装jdk

[root@oldboy ~]#rz -E

[root@oldboy ~]#ll

total 180016

-rw-r--r-- 1 root root 13867286 Apr 2 02:15 apache-tomcat-10.1.40.tar.gz

#如果已经安装了其他的JDK需要先卸载再安装新版本

[root@oldboy ~]#rpm -qa|grep java-11|xargs yum -y remove

[root@oldboy ~]#rpm -ivh jdk-8u181-linux-x64.rpm

2、拷贝代码和文件 ,web1执行

bash

[root@web01 /zrlog]#scp -rp /soft 10.0.0.8:/

[root@web01 /zrlog]#scp -rp /zrlog 10.0.0.8:/

[root@web01 /zrlog]#scp /usr/lib/systemd/system/tomcat.service 172.16.1.8:/usr/lib/systemd/system/tomcat.service

3、web02操作如下

bash#启动tomcat

[root@web02 /soft/tomcat]#systemctl start tomcat

[root@web02 /soft/tomcat]#systemctl enable tomcat

host解析

#浏览器访问测试

bash#上传图片测试

bashhost解析成10.0.0.7访问图片失败,因为上面的图片存到了8的本地磁盘里

4、挂载到nfs网络文件系统

bash#编辑配置文件

[root@nfs ~]#cat /etc/exports

/data/rw 172.16.1.0/24(rw,sync,all_squash,anonuid=200,anongid=200)

/data/ro 172.16.1.0/24(ro,sync,all_squash,anonuid=200,anongid=200)

/data/zrlog 172.16.1.0/24(ro,sync,all_squash,anonuid=200,anongid=200)

#创建路径

[root@nfs ~]#mkdir /data/zrlog

#拷贝图片

[root@web02 /soft/tomcat]#scp -r /zrlog/ROOT/attached/image/ 10.0.0.31:/data/zrlog

#授权

[root@nfs /data]#chown -R www.www zrlog/

#重启生效

[root@nfs /data]#systemctl restart nfs

#web01挂载

[root@web01 /soft/tomcat]#mount -t nfs 172.16.1.31:/data/zrlog /zrlog/ROOT/attached/

[root@web01 /soft/tomcat]#df -h

172.16.1.31:/data/zrlog 47G 3.8G 44G 9% /zrlog/ROOT/attached

#web02挂载

[root@web02 /soft/tomcat]#mount -t nfs 172.16.1.31:/data/zrlog /zrlog/ROOT/attached/

[root@web02 /soft/tomcat]#df -h

172.16.1.31:/data/zrlog 47G 3.8G 44G 9% /zrlog/ROOT/attached

#现在7也可以访问图片

5、配置负载均衡,Tomcat+Nginx+HTTPS

bash#修改配置文件

[root@lb01 /etc/nginx/conf.d]#cat zrlog.conf

upstream zrlog {

server 172.16.1.7:8080;

server 172.16.1.8:8080;

}

server {

listen 80;

server_name zrlog.oldboy.com;

location / {

proxy_pass http://zrlog;

include proxy_params;

}

}

# 加证书部署方式

upstream zrlog { # 定义后端服务器组(负载均衡池)

server 172.16.1.7:8080; # 后端服务器1

server 172.16.1.8:8080; # 后端服务器2

}

server {

listen 443 ssl; # 监听HTTPS端口(443)

server_name zrlog.oldboy.com; # 域名绑定

ssl_certificate ssl_key/server.crt; # SSL证书路径

ssl_certificate_key ssl_key/server.key; # SSL私钥路径

location / { # 处理所有请求

proxy_pass http://zrlog; # 将请求代理到上游服务器组

include proxy_params; # 包含代理通用参数配置

}

}

server {

listen 80; # 监听HTTP端口(80)

server_name zrlog.oldboy.com; # 域名绑定

return 302 https://$server_name$request_uri; # 强制跳转到HTTPS

}

#1、用户在浏览器输入 http://zrlog.oldboy.com 或直接访问该域名(默认匹配80端口)

#2、Nginx返回302重定向,浏览器自动跳转到 https://zrlog.oldboy.com

#3、浏览器与Nginx完成TLS握手,验证证书有效性(ssl_certificate 和 ssl_certificate_key)。

#4、监听端口:443,匹配server_name zrlog.oldboy.com 的server块

#5、反向代理到upstream组,加载通用代理参数

#6、Nginx根据默认轮询策略,选择 172.16.1.7:8080 或 172.16.1.8:8080 中的一个后端服务器。

#7、选中的后端服务器(如 172.16.1.7:8080)接收请求,处理业务逻辑

建立加密通道,后续数据传输均加密

[root@lb01 /etc/nginx/conf.d]#nginx -t

nginx: the configuration file /etc/nginx/nginx.conf syntax is ok

nginx: configuration file /etc/nginx/nginx.conf test is successful

[root@lb01 /etc/nginx/conf.d]#systemctl restart nginx

#浏览器访问测试:zrlog.oldboy.com,配置负载均衡不要加8080

4、Tomcat+Nginx+Redis会话保持

bash多种会话方式:1.ip_hash 2.mysql 3.redis

1、web01配置

bash#1.修改配置文件

[root@web01 ~]#vim /soft/tomcat/conf/server.xml

<Host name="session.oldboy.com" appBase="/session"

unpackWARs="true" autoDeploy="true">

<Valve className="org.apache.catalina.valves.AccessLogValve" directory="logs"

prefix="session_access_log" suffix=".log"

pattern="%h %l %u %t "%r" %s %b" />

</Host>

#2.创建数据

[root@web01 /soft/tomcat/conf]#mkdir -p /session/ROOT

[root@web01 /session/ROOT]#cat index.jsp

<body>

<%

//HttpSession session = request.getSession(true);

System.out.println(session.getCreationTime());

out.println("<br> web01 SESSION ID:" +

session.getId() + "<br>");

out.println("Session created time is :" +

session.getCreationTime()

+ "<br>");

%>

</body>

#3.重启

[root@web01 /session/ROOT]#systemctl restart tomcat

[root@web01 /session/ROOT]#netstat -tnulp

Active Internet connections (only servers)

Proto Recv-Q Send-Q Local Address Foreign Address State PID/Program name

tcp 0 0 0.0.0.0:22 0.0.0.0:* LISTEN 1081/sshd: /usr/sbi

tcp 0 0 127.0.0.1:9000 0.0.0.0:* LISTEN 1078/php-fpm: maste

tcp6 0 0 :::22 :::* LISTEN 1081/sshd: /usr/sbi

tcp6 0 0 :::8080 :::* LISTEN 6376/java

#4.解析域名

浏览器测试抓取

2、web02配置

bash#1.修改配置文件

[root@web02 /soft/tomcat]#vim conf/server.xml

<Host name="session.oldboy.com" appBase="/session"

unpackWARs="true" autoDeploy="true">

<Valve className="org.apache.catalina.valves.AccessLogValve" directory="logs"

prefix="session_access_log" suffix=".log"

pattern="%h %l %u %t "%r" %s %b" />

</Host>

#2.创建数据

[root@web02 /soft/tomcat]#mkdir /session/ROOT -p

[root@web02 /soft/tomcat]#vim /session/ROOT/index.jsp

[root@web02 /soft/tomcat]#cat /session/ROOT/index.jsp

<body>

<%

//HttpSession session = request.getSession(true);

System.out.println(session.getCreationTime());

out.println("<br> web02 SESSION ID:" +

session.getId() + "<br>");

out.println("Session created time is :" +

session.getCreationTime()

+ "<br>");

%>

</body>

#3.重启

[root@web02 /soft/tomcat]#systemctl restart tomcat

[root@web02 /soft/tomcat]#netstat -tnulp

bash#接入负载均衡

#1.编辑配置文件

[root@lb01 /etc/nginx/conf.d]#cat session.conf

upstream session {

server 172.16.1.7:8080;

server 172.16.1.8:8080;

}

server {

listen 80;

server_name session.oldboy.com;

location / {

proxy_pass http://session;

include proxy_params;

}

}

#2.重启

[root@lb01 /etc/nginx/conf.d]#nginx -t

nginx: the configuration file /etc/nginx/nginx.conf syntax is ok

nginx: configuration file /etc/nginx/nginx.conf test is successful

[root@lb01 /etc/nginx/conf.d]#systemctl restart nginx

#浏览器访问测试,无会话保持:

bash#接入TomcatClusterRedisSessionManager

#1.上传

[root@web01 ~]#ll

-rw-r--r-- 1 root root 921429 Apr 21 17:01 tomcat-cluster-redis-session-manager.zip

#2.解压zip包

[root@web01 ~]#unzip tomcat-cluster-redis-session-manager.zip

#3.拷贝jars到tomcat的/lib目录中

[root@web01 ~]#cp tomcat-cluster-redis-session-manager/lib/* /soft/tomcat/lib/

#4.拷贝conf下的redis.properties文件,到tomcat的conf文件

[root@web01 ~]#cp tomcat-cluster-redis-session-manager/conf/redis-data-cache.properties /soft/tomcat/conf/

#5.将配置文件中连接redis地址修改为如下地址即可

[root@web01 ~]#vim /soft/tomcat/conf/redis-data-cache.properties

redis.hosts=172.16.1.51:6379

redis.password=123

#6.添加如下两行至tomcat/conf/context.xml (添加在</Context> 上一行 )

[root@web01 ~]# vim /soft/tomcat/conf/context.xml

<Valve className="tomcat.request.session.redis.SessionHandlerValve" />

<Manager className="tomcat.request.session.redis.SessionManager" />

</Context>

[root@web01 ~]#rsync -avz /soft/tomcat/ --delete 10.0.0.8:/soft/tomcat

#修改完成后重启Tomcat

这里出现个错误Valve打成了value导致400错误

bash#redis数据库测试

[root@db01 ~]#redis-cli

127.0.0.1:6379> keys *

(error) NOAUTH Authentication required.

127.0.0.1:6379> auth 123

OK

127.0.0.1:6379> keys *

(empty array)

127.0.0.1:6379>

127.0.0.1:6379> keys *

1) "5BCBABBC154E7CAFF45D246281FB0BAC"

2) "PHPREDIS_SESSION:18um6d4t97odef790b26d6srtm"

#浏览器测试,一个seeion值

5、部署最新版zrlog

不需要额外部署tomcatweb服务

bash#用199服务器来实现

#1.安装数据库

1.安装数据库服务

[root@db01 ~]# yum -y install mariadb-server

2.启动服务

[root@db01 ~]# systemctl start mariadb-server

3.登录

[root@db01 ~]#mysql -uroot -plzy123.com

Welcome to the MariaDB monitor. Commands end with ; or \g.

Your MariaDB connection id is 8

Server version: 10.3.39-MariaDB MariaDB Server

Copyright (c) 2000, 2018, Oracle, MariaDB Corporation Ab and others.

Type 'help;' or '\h' for help. Type '\c' to clear the current input statement.

4.创建数据库

MariaDB [(none)]> create database zrlog_test;

Query OK, 1 row affected (0.001 sec)

MariaDB [(none)]> show databases;

+--------------------+

| Database |

+--------------------+

| information_schema |

| mysql |

| performance_schema |

| wordpress |

| zrlog |

| zrlog_test |

+--------------------+

6 rows in set (0.043 sec)

bash#2.下载JDK

[root@oldboy ~]# wget https://download.oracle.com/java/21/latest/jdk-21_linux-x64_bin.rpm

#3.下载源代码

[root@web02 /opt]#wget https://dl.zrlog.com/release/zrlog.zip

解压代码到/opt/zrlog下

[root@oldboy ~]#cd /opt/zrlog/

[root@web02 /opt/zrlog]#ll

total 32

drwxr-xr-x 2 root root 53 Apr 10 08:59 bin

drwxr-xr-x 2 root root 59 Mar 24 00:51 doc

drwxr-xr-x 2 root root 4096 Mar 24 00:51 lib

-rw-r--r-- 1 root root 11358 Mar 24 00:51 LICENSE

-rw-r--r-- 1 root root 3113 Mar 24 00:51 README.en-us.md

-rw-r--r-- 1 root root 4200 Mar 24 00:51 README.md

-rw-r--r-- 1 root root 3335 Mar 24 00:51 zrlog-starter.jar

#4.启动一定要看jar包的路径

[root@web02 /opt/zrlog]#ll

total 32

drwxr-xr-x 2 root root 70 Apr 23 09:16 bin

drwxr-xr-x 2 root root 59 Mar 24 00:51 doc

drwxr-xr-x 2 root root 4096 Mar 24 00:51 lib

-rw-r--r-- 1 root root 11358 Mar 24 00:51 LICENSE

-rw-r--r-- 1 root root 3113 Mar 24 00:51 README.en-us.md

-rw-r--r-- 1 root root 4200 Mar 24 00:51 README.md

-rw-r--r-- 1 root root 3335 Mar 24 00:51 zrlog-starter.jar

[root@web02 /opt/zrlog]##sh bin/start.sh # 启动方法1

或者使用

[root@web02 /opt/zrlog]#nohup java -Xmx48m -Dfile.encoding=UTF-8 -jar zrlog-starter.jar & # 启动方法2

[root@oldboy zrlog]# netstat -tnulp

Active Internet connections (only servers)

Proto Recv-Q Send-Q Local Address Foreign Address State PID/Program name

tcp 0 0 0.0.0.0:22 0.0.0.0:* LISTEN 1089/sshd: /usr/sbi

tcp6 0 0 :::8080 :::* LISTEN 1892/java

tcp6 0 0 :::22 :::* LISTEN 1089/sshd: /usr/sbi

udp 0 0 127.0.0.1:323 0.0.0.0:* 768/chronyd

udp6 0 0 ::1:323 :::* 768/chronyd

#浏览器访问测试:10.0.0.199:8080

14、阿里云平台

1、云基本介绍

bash#1.什么是云

云是一种”按需付费的模式“,这种模式提供了(计算、存储、网络等资源),这些资源能够被快速提供。

1.包年包月;

2.按需付费; SIM流量一样; 用多少给多少钱;

云只是一种思想,并不是某种具体的技术;

云需要依托于 虚拟化技术才可以实现;

#2.云的分类

公有云:阿里云、腾讯云、亚马逊云。只有使用权,按需付费(技术层面:数据不安全)

私有云:自建机房,自己搭建,所有自行管理,将真实的物理服务器逻辑捆绑成一个虚拟资源池,用户可以根据虚拟资源池按需使用,资源是固定。

私有云; vmware,ESXI5.4(集成了操作系统和虚拟化软件),在公司, 使用多台性能较高的物理主机, 逻辑组成一个庞大资源池;根据业务需要,进行按需创建,使用对应的资源;不对外开放,仅对本公司开放;

好处: 数据安全,

劣势:1.自己维护,自己管理,成本高;

2.无法快速的扩展节点;

# 那私有云跟传统机房有啥区别啊,都是自己弄物理设备

私有云: 多台机器逻辑捆绑在一起;组成的资源池; --> 系统平台;

传统机房: 物理机器托管在机房; 在物理机上运行资源;

IDC机房: 城市的机房位置。

混合云(主要业务放私有云、当有临时需求的时候使用公有云,使用结束后释放)

按需使用、按需付费、保证业务稳定的同时,也能节省一定的成本。

两类场景:

1.公司正常的业务运行,资源不够, 借助公有云来快速,高效扩展业务;

2.重要的业务,核心的业务,在私托有云平台、官网、OA、等等不是很敏感的信息,托管在公有云;

#3为什么要用云

1)海量资源池灵活调配 [像大海一样|无尽头]

2)无处不在的网络访问 [随时随地能访问云资源]

3)随需应变的自助服务 [包年包月-电话卡|按需付费-流量包]

4)保证服务的高可用性

5)能实现快速弹性伸缩 [扩展|伸缩|自愈]

#4云有哪些厂商

1) 阿里云 | 腾讯云 | Ucloud | 青云 | [ AWS ]

2) 华为云 | 京东云 | 滴滴云 |

#5云上面的产品名词

1)物理服务器 --> 阿里云

2)服务器 --> ECS、快照、镜像,克隆;

3)负载均衡 --> SLB

4) 数据库 --> RDS

5) 存储服务NFS --> NAS、OSS

5) 防火墙 --> 安全组iptables,firewalld、高防IP、WAF

6)远程访问 --> VPN | JumpServer + OpenVPN

7) 消息队列 --> MQ

8) 网络 --> 弹性网卡 NAT

2、ECS产品使用

bash云服务器(Elastic Compute Service,简称 ECS),是一种简单高效、可弹性伸缩的计算服务。

比如: 当服务器运行负荷不够时,通常的做法是增加服务器,那么增加服务器的流程和步骤如下:

1.购买硬件,拆开服务器、安装硬件设备。

2.部署系统、部署应用、接入集群。

但如果使用云主机,可以实现自动化感知、自动化扩展集群。

#1.ECS地域与可用区说明

https://help.aliyun.com/document_detail/188196.html?spm=a2c4g.11186623.6.556.3e5e53c0ZQ8lpP

地域: 指的是一个城市,比如北京;

可用区: 指的是城市下面的区,北京可用区A和北京可用区B等;

1.相同地域,不同可用区之间的内网是互通的;

2.不同地域,相同可用区,内网不互通; 但是我们可以通过技术手段来实现互联互通;

3.每一个地域,都有一个VPC路由器; 每一个可用区都需要有一个交换机; 所有的交换机都是连接的同一个VPC路由器;

#2.ECS云主机配置选型

web节点: 4c x 16Gb

DB节点: 4c x 64Gb 4c x 32Gb 12c x 128GB 建议使用:SSD 性能会受到磁盘的限制;

数据迁移 将物理机的服务 --> 云主机

故障案例:

4c x 64GB 物理机 磁盘 SATA = 400Mbps

4c x 64GB 云主机 磁盘 高效盘 100Mbps | SSD 固态盘 = 400Mbps

dd | hdparm -t /dev/vda1

#3.ECS中的网络简要说明

EIP: 弹性公网IP

SLB: 负载均衡

NAT: 网关设备

VPN: 远程访问服务

VPC: 软件路由器 ( 可以创建交换机, 可以在每个可用区都创建 )

VPC文档:https://help.aliyun.com/document_detail/54095.html?spm=5176.11182174.content.1.4411488295LcKx#title-oil-ncn-266

1、产品架构

bash# ECS云服务逻辑架构

通过账号登录,从管理员入口进入-->通过地域/可用区购买自己的ECS-->购买成功后通过Workbench/VNC访问服务器,也可以通过远程命令去控制它,也可以通过SSH登录Linux-->费用可以包年包月等等

可以对ECS做数据的存储-->可以做数据备份,也可以把/做一个快照(快照可以回滚云盘)---基于快照创建镜像---基于快照启动实例

可以对ERC做一个弹性网卡,可以绑定公网ip,从任意一个地方可以访问就绑定公网

2、产品购买

bash1.登录--产品--云服务器ECS--立即购买--自定义购买,选择配置

3、ECS挂载磁盘

bash#云服务器:

进入实例-->点击块存储-->创建云盘

bash选好自己的地域,从哪里买ECS选哪里,最后点确认下单

!

bash创建成功后,点击前往示例云盘列表,可以看到多出来的数据盘

bash#1.查看磁盘信息,可以看到/dev/vdb

[root@aliyun ~]#fdisk -l

Disk /dev/vda: 42.9 GB, 42949672960 bytes, 83886080 sectors

Units = sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 512 bytes / 512 bytes

Disk label type: dos

Disk identifier: 0x000edc45

Device Boot Start End Blocks Id System

/dev/vda1 * 2048 83886046 41941999+ 83 Linux

Disk /dev/vdb: 21.5 GB, 21474836480 bytes, 41943040 sectors

Units = sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 512 bytes / 512 bytes

#2.格式化:

[root@web01 ~]# mkfs.xfs /dev/vdb

meta-data=/dev/vdb isize=512 agcount=4, agsize=3276800 blks

= sectsz=512 attr=2, projid32bit=1

= crc=1 finobt=0, sparse=0

data = bsize=4096 blocks=13107200, imaxpct=25

= sunit=0 swidth=0 blks

naming =version 2 bsize=4096 ascii-ci=0 ftype=1

log =internal log bsize=4096 blocks=6400, version=2

= sectsz=512 sunit=0 blks, lazy-count=1

realtime =none extsz=4096 blocks=0, rtextents=0

#3.挂载

[root@web01 ~]# mount /dev/vdb /mnt

[root@web01 ~]# df -h

/dev/vdb 20G 33M 50G 1% /mnt

#4.创建测试数据

[root@aliyun ~]#cd /mnt

[root@aliyun /mnt]#touch {1..10}.log

[root@aliyun /mnt]#ll

total 0

-rw-r--r-- 1 root root 0 Apr 23 18:02 10.log

-rw-r--r-- 1 root root 0 Apr 23 18:02 1.log

-rw-r--r-- 1 root root 0 Apr 23 18:02 2.log

-rw-r--r-- 1 root root 0 Apr 23 18:02 3.log

-rw-r--r-- 1 root root 0 Apr 23 18:02 4.log

-rw-r--r-- 1 root root 0 Apr 23 18:02 5.log

-rw-r--r-- 1 root root 0 Apr 23 18:02 6.log

-rw-r--r-- 1 root root 0 Apr 23 18:02 7.log

-rw-r--r-- 1 root root 0 Apr 23 18:02 8.log

-rw-r--r-- 1 root root 0 Apr 23 18:02 9.log

在线扩容:

云盘--> 选择50G的数据盘 在线扩容到100G

#5.回到块存储,点击三个点,选择扩容

bash#6.执行命令扩容文件系统

[root@web01 ~]# xfs_growfs /mnt

meta-data=/dev/vdb isize=512 agcount=4, agsize=1310720 blks

= sectsz=512 attr=2, projid32bit=1

= crc=1 finobt=0 spinodes=0

data = bsize=4096 blocks=5242880, imaxpct=25

= sunit=0 swidth=0 blks

naming =version 2 bsize=4096 ascii-ci=0 ftype=1

log =internal bsize=4096 blocks=2560, version=2

= sectsz=512 sunit=0 blks, lazy-count=1

realtime =none extsz=4096 blocks=0, rtextents=0

data blocks changed from 5242880 to 15728640

#7.查看已经扩容到了60G

[root@aliyun /mnt]#df -h

/dev/vdb 60G 33M 60G 1% /mnt

#8.查看文件还存在

[root@aliyun /mnt]#ll

total 0

-rw-r--r-- 1 root root 0 Apr 23 18:02 10.log

-rw-r--r-- 1 root root 0 Apr 23 18:02 1.log

-rw-r--r-- 1 root root 0 Apr 23 18:02 2.log

-rw-r--r-- 1 root root 0 Apr 23 18:02 3.log

-rw-r--r-- 1 root root 0 Apr 23 18:02 4.log

-rw-r--r-- 1 root root 0 Apr 23 18:02 5.log

-rw-r--r-- 1 root root 0 Apr 23 18:02 6.log

-rw-r--r-- 1 root root 0 Apr 23 18:02 7.log

-rw-r--r-- 1 root root 0 Apr 23 18:02 8.log

-rw-r--r-- 1 root root 0 Apr 23 18:02 9.log

# 如果已经格式化后再执行会报错

[root@git ~]#mkfs.xfs /dev/vdb

mkfs.xfs: /dev/vdb appears to contain an existing filesystem (xfs).

mkfs.xfs: Use the -f option to force overwrite.

# 通过blkid命令查看,如果已格式化,输出会显示文件系统类型和 UUID

[root@git ~]#blkid /dev/vdb

/dev/vdb: UUID="b52efd9a-09a1-41aa-96c8-bc6240d57bab" TYPE="xfs"

#卸载云盘

[root@aliyun /]#umount /mnt

[root@aliyun /]#df -h

Filesystem Size Used Avail Use% Mounted on

devtmpfs 868M 0 868M 0% /dev

tmpfs 879M 0 879M 0% /dev/shm

tmpfs 879M 492K 878M 1% /run

tmpfs 879M 0 879M 0% /sys/fs/cgroup

/dev/vda1 40G 2.7G 35G 8% /

tmpfs 176M 0 176M 0% /run/user/0

#点击卸载

bash#点击释放,释放完成

4、ECS搭建kodcloud

bash#1.安装Nginx

[root@web01 /]#yum -y install nginx

#2.配置Nginx

[root@web01 /etc/nginx/conf.d]#cat kod.conf

server {

listen 80;

server_name kod.weixinag.info;

location / {

root /code;

index index.php index.html;

}

location ~ \.php$ {

root /code;

fastcgi_pass 127.0.0.1:9000;

fastcgi_param SCRIPT_FILENAME $document_root$fastcgi_script_name;

include fastcgi_params;

}

}

#创建目录并修改权限

[root@web01 ~]#mkdir /code

[root@web01 /code]#chown -R nginx.nginx /code

#3.启动Nginx

[root@web01 /etc/nginx/conf.d]#nginx -t

nginx: the configuration file /etc/nginx/nginx.conf syntax is ok

nginx: configuration file /etc/nginx/nginx.conf test is successful

[root@web01 /etc/nginx/conf.d]#systemctl restart nginx

[root@web01 /etc/nginx/conf.d]#systemctl enable nginx

#4.PHP-FPM 上传安装

[root@web01 ~]#tar xf php71.tar.gz

#因为安装包互相有依赖,所以全包安装

[root@web01 ~]#yum -y localinstall *.rpm

#5.修改配置文件并启动php

[root@web01 /code]#cat -n /etc/php-fpm.d/www.conf

8 user = nginx

10 group = nginx

[root@web01 ~]#systemctl start php-fpm.service

[root@web01 ~]#systemctl enable php-fpm.service

Created symlink from /etc/systemd/system/multi-user.target.wants/php-fpm.service to /usr/lib/systemd/system/php-fpm.service.

[root@web01 ~]#netstat -tnulp

Active Internet connections (only servers)

Proto Recv-Q Send-Q Local Address Foreign Address State PID/Program name

tcp 0 0 0.0.0.0:22 0.0.0.0:* LISTEN 1028/sshd

tcp 0 0 127.0.0.1:25 0.0.0.0:* LISTEN 998/master

tcp 0 0 127.0.0.1:9000 0.0.0.0:* LISTEN 1466/php-fpm: maste

#6.下载可道云

[root@web01 /code]#wget https://static.kodcloud.com/update/download/kodbox.1.30.zip

#7.解压

[root@web01 /code]#unzip kodbox.1.30.zip

#浏览器登录,要在安全组--管理规则中放行80端口,要不连接失败

5、ECS快照与镜像

bash#1.云服务器ECS--实例--选择其中一个实例--块存储--创建快照,基于快照可以回滚文件

#测试,删除root下的所有文件,通过回滚云盘可以把文件回复,基于公司需求可以创建自动快照策略,分周跟小时

ECS快照

3.1)快照基本介绍

3.2)快照使用场景

3.3)快照使用方式

手动创建快照

自动创建快照

Document:https://help.aliyun.com/document_detail/25391.html?spm=a2c4g.11186623.6.823.73175b2cIbssVu

测试: 将web01的代码删除

通过页面无法访问

通过快照恢复再次访问

bash#2.创建完成后点击快照可以看到,等进度完成100%,点击创建自定义镜像,基于快照创建镜像

bash#3.点击左侧的镜像可以看到创建的镜像,基于镜像可以启动实例

6、通过ECS镜像启动新的实例

bash镜像概述:https://help.aliyun.com/zh/ecs/user-guide/image-overview?spm=a2c4g.11186623.0.i0 其他正常选,镜像选择自己保存的

7、配置负载均衡

bash购买负载均衡服务器

bash把web服务器的弹性ip解绑,绑定到负载均衡服务器,解绑后xshell连不上了,只能通过页面去连接

bash回到负载均衡,绑定EIP

bash这个地方相当于upstream{ server xxxxxx 80; server xxxxxx 80; }

bash可以看到负载均衡已经转发到后端两台了

bash#输入负载均衡的公网ip,浏览器测试可以正常访问

bash#登录页面,查看日志,没问题

bash面试:阿里云怎么配的负载均衡 先购买传统型负载均衡服务器,然后去配置,选择http或者https,选择端口。然后下一步选择后面两台的web,默认使用轮询的方式

部署完释放资源

3、快速恢复kod业务

1、基于镜像恢复实例

2、部署负载均衡

bash通过公网ip测试访问没问题

4、云解析DNS

bash#1、DNS智能解析

1.传统DNS解析,不判断访问者来源,会随机选择其中一个IP地址返回给访问者。而智能DNS解析,会判断访问者的来源,为不同的访问者智能返回不同的IP地址,使访问者在访问网站时获取指定的IP地址,能够减少解析时延,并提升网站访问速度。

传统DNS解析示例

例如域名www.cloud-example.com,有三台服务器,分别是联通IP,移动IP和电信IP,DNS解析配置如下:

将域名指向联通IP地址 (192.x.x.1)

将域名指向移动IP地址 (192.x.x.2)

将域名指向电信IP地址 (192.x.x.3)

实现的解析效果:

传统DNS解析不判断访问者的来源,会将192.x.x.1、192.x.x.2、192.x.x.3三个地址全部返回给访问者的LocalDNS,由访问者的LocalDNS通过随机或者优选的方式将其中一个IP地址返回给访问者,传统DNS解析有可能会造成访问者跨网访问。

2.智能DNS解析示例

例如域名www.cloud-example.com被解析到3个IP地址,分别是联通IP,移动IP和电信IP,DNS解析配置如下:

解析请求来源配置 默认 指向联通IP地址 (192.x.x.1)

解析请求来源配置 中国移动 指向移动IP地址 (192.x.x.2)

解析请求来源配置 中国电信 指向电信IP地址 (192.x.x.3)

实现的解析效果:云解析会判断访问者的来源:

为来源于中国移动运营商的访问者返回192.x.x.2的解析地址;

为来源于中国电信运营商的访问者返回192.x.x.3的解析地址;

为其他来源的访问者返回192.x.x.1的解析地址。

1、DNS解析过程

bashDNS解析过程 通过域名example.com访问网站的域名解析过程如下。 1、用户在Web浏览器中输入“example.com”, 向本地域名服务器发起查询请求。若本地域名服务器存在缓存的解析数据,则直接将域名example.com对应的IP地址返回给Web浏览器,跳至步骤9。若本地域名服务器没有查到缓存的解析数据,则继续步骤2。 2、本地域名服务器向根域名服务器进行查询。 3、根域名服务器将.com顶级域名服务器的地址,返回给本地域名服务器。 4、本地域名服务器向.com顶级域名服务器发起example.com的查询请求。 5、.com顶级域名服务器将为example.com提供权威解析的权威域名服务器地址,返回给本地域名服务器。 6、本地域名服务器向权威域名服务器发起查询请求。 7、权威域名服务器将域名example.com对应的IP地址,返回给本地域名服务器。 8、本地域名服务器最后把查询的IP地址响应给Web浏览器。 9、Web浏览器通过IP地址访问网站服务器。 10、网站服务器返回网页信息。

2、记录概览

云解析支持的记录类型及其常见应用场景:

| 记录类型 | 说明及场景 |

|---|---|

| A记录 | 将域名解析到指定的IPv4地址。常用于网站域名解析。 |

| CNAME 记录 | 将一个域名解析到另一个域名。常用于网站解析、CDN域名加速、企业邮箱、全局流量管理接入等。访问这个域名跳转到别的域名 |

| TXT 记录 | 用于对域名进行标识和说明。常用于数字认证证书、SPF 记录(反垃圾邮件)、域名找回等场景。验证来使用 |

3、配置域名解析

bash将kodd.weixiang.info解析到SLB公网ip

bash#ping域名测试:

C:\Users\z1340>ping weixiang.info

正在 Ping weixiang.info [8.148.226.254] 具有 32 字节的数据:

来自 8.148.226.254 的回复: 字节=32 时间=38ms TTL=87

来自 8.148.226.254 的回复: 字节=32 时间=40ms TTL=87

C:\Users\z1340>ping kod.weixiang.info

正在 Ping kod.weixiang.info [8.148.226.254] 具有 32 字节的数据:

来自 8.148.226.254 的回复: 字节=32 时间=38ms TTL=87

来自 8.148.226.254 的回复: 字节=32 时间=38ms TTL=87

#浏览器访问测试

5、配置HTTPS证书

bash创建证书

bash回到传统型负载均衡

bash下一步-下一步-提交

bash#现在配置好了,浏览器正常登录,但是有个问题,现在配置了80、443两个监听端口,分别创建了两种转发方式,没有创建80跳转到443的方式,所以需要删掉80端口,配置80转443的监听方式

bash#修改web01与web02配置文件,开启https

#浏览器测试,正常进入

需要修改的配置

bash# 后端web服务器需要开启fastcgi_param HTTPS on;

[root@iZ7xv58a45kz3zmvjl2vajZ ~]#cat /etc/nginx/conf.d/kod.conf

server {

listen 80;

server_name linux.weixiang.info; # server_name,域名

location / {

root /code/kid;

index index.php index.html;

}

location ~ \.php$ {

root /code/kid;

fastcgi_pass 127.0.0.1:9000;

fastcgi_param SCRIPT_FILENAME $document_root$fastcgi_script_name;

include fastcgi_params;

fastcgi_param HTTPS on; # 这里要开启

}

}

6、四层负载

bash标准架构高可用类型采用主备(master-replica)模式搭建。主节点提供日常服务访问,备节点通常不对外提供服务,仅保障高可用性(HA)。当主节 点发生故障,系统会自动在30秒内切换至备节点,保证业务平稳运行。 web服务器跟后端连接都是lvs四层负载,以ip+端口的方式访问,方便做故障切换,web直接连接数据库的话,数据库有故障只能手动修改配置文件再 切换。存在lvs四层负载,web连接lvs的vip(虚拟ip),vip绑定在后端一台数据库上,所以web访问vip就是访问绑定vip的后端数据库,如果数据库 故障,vip会自动飘移到另一台数据库上,如果数据库之间有会话保持,那么数据也不会少

1、配置四层负载

bash#四层转发只能对一个域名

bashxshell连接8.148.226.254的2222端口

bashTCP的2222端口转发到web01的22端口

7、Redis集群

1、高可用概念

标准架构高可用类型采用主备(master-replica)模式搭建。主节点提供日常服务访问,备节点通常不对外提供服务,仅保障高可用性(HA)。当主节点发生故障,系统会自动在30秒内切换至备节点,保证业务平稳运行。

bash标准架构高可用类型的特点如下: 服务可靠:采用双机主备(master-replica)架构,主备节点位于不同物理机。当主节点出现故障,自研的HA系统会自动进行主备切换,保证业务平稳运行。 数据可靠:默认开启数据持久化功能,数据全部落盘。支持数据备份功能,您可以针对备份集回滚实例或者克隆实例,有效地解决数据误操作等问题。同时,在支持容灾的可用区(例如杭州可用区H+I)创建的实例,还具备同城容灾的能力。 兼容性:完全兼容Redis协议,自建的Redis数据库可以平滑迁移Redis标准版。阿里云还提供数据传输工具(DTS)进行增量的Redis迁移,保证业务平稳过渡。 阿里云自研 故障探测切换系统(HA): 云数据库Tair(兼容 Redis)封装HA切换系统,实时探测主节点的异常情况,可以有效解决磁盘IO故障,CPU故障等问题导致的服务异常,及时进行主备切换,从而保证服务高可用。 主备复制机制: 云数据库Tair(兼容 Redis)对主备全量同步中的Fork问题进行了优化,实现了无阻塞,在增量同步中采用增量日志格式进行复制传输。当主备复制中断后,对系统性能及稳定性影响极低,有效地避免了Redis原生主备复制的弊端。

2、部署redis实现kod会话保持

bash1.购买redis服务器

bash2.查看购买的redis基础信息,添加白名单,才能链接

bash设置完白名单后返回实例会出现个链接地址

bash3.ping测试,要用同一网段才能ping通,slb四层转发后连接到的内网地址可以ping通

#ping这个地址会发现自动获得的ip是同一地域下的172.29.93.22

[root@web01 ~]#ping r-7xvjstzmnearjq1tbe.redis.rds.aliyuncs.com

PING r-7xvjstzmnearjq1tbe.redis.rds.aliyuncs.com (172.29.93.22) 56(84) bytes of data.

64 bytes from 172.29.93.22 (172.29.93.22): icmp_seq=1 ttl=102 time=0.557 ms

64 bytes from 172.29.93.22 (172.29.93.22): icmp_seq=2 ttl=102 time=0.559 ms

64 bytes from 172.29.93.22 (172.29.93.22): icmp_seq=3 ttl=102 time=0.538 ms

4.修改免密登录,添加数据库信息

bash配置完后,页面访问失败,这是因为设置免密登录失败了,重新设置了下,可以正常访问

bash5.因为有两台web服务器,而nginx负载均衡以轮询的方式配置了其中一台,所以只把某一台的配置文件写到了后端数据库 ,所以需要找到哪台配置 了redis的账号信息,复制到另外一台。所以最好的方式是先配置其中一台web的配置文件,然后拷贝到另一台。通过网页填写的方式不知道会写到 哪一台

bash6.配置另一台web

#递归查找r-7xvjstzmnearjq1tbe.redis.rds.aliyuncs.com保存在/code下哪个目录

[root@iZ7xvdbtdxwjcty17oye0dZ /]#grep -r r-7xvjstzmnearjq1tbe.redis.rds.aliyuncs.com /code

/code/config/setting_user.php:$config['cache']['redis']['host'] = 'r-7xvjstzmnearjq1tbe.redis.rds.aliyuncs.com';

#查看

[root@iZ7xvdbtdxwjcty17oye0dZ /]#cat /code/config/setting_user.php

<?php

$config['database'] = array (

'DB_TYPE' => 'sqlite3',

'DB_NAME' => USER_SYSTEM.'d5IJnDm6atPX.php',

'DB_SQL_LOG' => true,

'DB_FIELDS_CACHE' => true,

'DB_SQL_BUILD_CACHE' => false,

);

$config['cache']['sessionType'] = 'file';

$config['cache']['cacheType'] = 'file';

$config['cache']['sessionType'] = 'redis';

$config['cache']['cacheType'] = 'redis';

$config['cache']['redis']['host'] = 'r-7xvjstzmnearjq1tbe.redis.rds.aliyuncs.com';

$config['cache']['redis']['port'] = '6379';

$config['cache']['sessionType'] = 'redis';

$config['cache']['cacheType'] = 'redis';

$config['cache']['redis']['host'] = 'r-7xvjstzmnearjq1tbe.redis.rds.aliyuncs.com';

$config['cache']['redis']['port'] = '6379'

#将文件拷贝过去

[root@iZ7xvdbtdxwjcty17oye0dZ /]#scp /code/config/setting_user.php 172.22.233.224:/code/config/

The authenticity of host '172.22.233.224 (172.22.233.224)' can't be established.

ECDSA key fingerprint is SHA256:do2XH/bkTOZjHpEX7lxS52FExhRfExyz8Imv3SzNhA8.

ECDSA key fingerprint is MD5:84:fb:aa:97:8c:19:65:5d:e7:05:a4:c1:05:33:61:6a.

Are you sure you want to continue connecting (yes/no)? yes

Warning: Permanently added '172.22.233.224' (ECDSA) to the list of known hosts.

root@172.22.233.224's password:

setting_user.php

#浏览器测试。正常

3、外网链接Redis

bash#1要开启公网,2添加白名单,3新建用户密码远程连接

1.申请链接公网地址,刷新后可以看到

bash2.访问测试,随便可以联网的电脑都可以ping通

[root@web02 ~]#ping r-7xvjstzmnearjq1tbepd.redis.rds.aliyuncs.com

PING r-7xvjstzmnearjq1tbepd.redis.rds.aliyuncs.com (8.148.168.150) 56(84) bytes of data.

64 bytes from 8.148.168.150 (8.148.168.150): icmp_seq=1 ttl=128 time=67.2 ms

64 bytes from 8.148.168.150 (8.148.168.150): icmp_seq=2 ttl=128 time=35.3 ms

3.登录数据库

[root@db01 ~]#redis-cli -h r-7xvjstzmnearjq1tbepd.redis.rds.aliyuncs.com

4.查看数据库报错,显示服务器关闭了连接,要放行白名单(出网的公网ip,通过curl cip.cc命令),设置用户名密码

# 查看公网ip

[root@db01 ~]#curl cip.cc

IP : 123.117.19.236

地址 : 中国 北京 北京

运营商 : 联通

数据二 : 中国北京北京 | 联通

数据三 : 中国北京北京市 | 联通

URL : http://www.cip.cc/123.117.19.236

bash5.可以正常登录数据库

[root@db01 ~]#redis-cli -h r-7xvjstzmnearjq1tbepd.redis.rds.aliyuncs.com -a 'oldboy:oldboy123!'

r-7xvz1v70hylxkkk5nnpd.redis.rds.aliyuncs.com:6379> keys *

14298) "c2de1abb7018147446cdc1363d7941ec"

14299) "c4d8d9bfeb404b80fbd72daa8f317c72"

14300) "7ced0dd25a2648efe2b54089daa5b9bf"

14301) "4f47d74bc7730b4f5d0f594e8e51172e"

14302) "b255220aedf062c9d8e2c272e89505c3"

14303) "a3052762f7c8bab344324086702f6063"

14304) "2ae6bcc0b86482de55c2c8e28862f3a1"

14305) "48d1e8773ba74b97d6bdcd73db635437"

14306) "8772d3bd43e1269bd35a95cbe8a0ceca"

(1.06s)

4、Redis规格升级

5、卸载redis会话保持

bash#进入配置文件把redis相关的删除

vim /code/config/setting_user.php

#访问已经看不到了

8、kod接入mysql

bash1.购买一台mysql数据库 2.查看ip地址

bash[root@web01 ~]#ip a

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN group default qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

inet6 ::1/128 scope host

valid_lft forever preferred_lft forever

2: eth0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast state UP group default qlen 1000

link/ether 00:16:3e:03:b1:90 brd ff:ff:ff:ff:ff:ff

inet 172.22.233.223/20 brd 172.22.239.255 scope global dynamic eth0

valid_lft 1892145632sec preferred_lft 1892145632sec

inet6 fe80::216:3eff:fe03:b190/64 scope link

valid_lft forever preferred_lft forever

[root@web01 ~]#ping rm-7xvn9qi9495vfku4y.mysql.rds.aliyuncs.com

PING rm-7xvn9qi9495vfku4y.mysql.rds.aliyuncs.com (172.22.233.225) 56(84) bytes of data.

64 bytes from 172.22.233.225 (172.22.233.225): icmp_seq=1 ttl=102 time=0.222 ms

64 bytes from 172.22.233.225 (172.22.233.225): icmp_seq=2 ttl=102 time=0.173 ms

3.创建账号密码

bash4.安装mysql客户端

[root@web01 ~]#yum -y install mysql

5.登录

[root@web01 ~]#mysql -h rm-7xvn9qi9495vfku4y.mysql.rds.aliyuncs.com -uoldboy -pSdms2018

Welcome to the MariaDB monitor. Commands end with ; or \g.

Your MySQL connection id is 915

Server version: 8.0.36 Source distribution

Copyright (c) 2000, 2018, Oracle, MariaDB Corporation Ab and others.

Type 'help;' or '\h' for help. Type '\c' to clear the current input statement.

MySQL [(none)]>

#添加数据库信息

bash因为有两台web服务器,而nginx负载均衡以轮询的方式配置了其中一台,所以只把某一台的配置文件写到了后端数据库 ,所以需要找到哪台配置了mysql的账号信息,复制到另外一台。所以最好的方式是先配置其中一台web的配置文件,然后拷贝到另一台。通过网页填写的方式不知道会写到哪一台

#查看哪一台web有mysql配置信息

[root@iZ7xvdbtdxwjcty17oye0eZ ~]#cat /code/config/setting_user.php

<?php

$config['database'] = array (

'DB_TYPE' => 'sqlite3',

'DB_NAME' => USER_SYSTEM.'d5IJnDm6atPX.php',

'DB_SQL_LOG' => true,

'DB_FIELDS_CACHE' => true,

'DB_SQL_BUILD_CACHE' => false,

);

$config['cache']['sessionType'] = 'file';

$config['cache']['cacheType'] = 'file';

$config['database'] = array (

'DB_TYPE' => 'mysqli',

'DB_NAME' => 'kodbox',

'DB_HOST' => 'rm-7xvn9qi9495vfku4y.mysql.rds.aliyuncs.com',

'DB_PORT' => 3306,

'DB_USER' => 'oldboy',

'DB_PWD' => 'oldboy123!',

'DB_SQL_LOG' => true,

'DB_FIELDS_CACHE' => true,

'DB_SQL_BUILD_CACHE' => false,);

#将配置文件复制到另外一台web

#配置好访问测试

bash#mysql发现数据库已经存在

MySQL [(none)]> show databases;

+--------------------+

| Database |

+--------------------+

| __recycle_bin__ |

| information_schema |

| kodbox |

| mysql |

| performance_schema |

| sys |

+--------------------+

6 rows in set (0.01 sec)

1、升级读写分离

bash修改数据库配置,把内网连接地址放到php文件

[root@web01 ~]#vim /code/config/setting_user.php

9、NAS

1、挂载

bash购买一台nas服务器

bash#查看。已经完成自动挂载

[root@iZ7xv5bq4vfmj0398fehyiZ ~]#df -h

Filesystem Size Used Avail Use% Mounted on

devtmpfs 485M 0 485M 0% /dev

tmpfs 496M 0 496M 0% /dev/shm

tmpfs 496M 524K 495M 1% /run

tmpfs 496M 0 496M 0% /sys/fs/cgroup

/dev/vda1 40G 3.1G 35G 9% /

tmpfs 100M 0 100M 0% /run/user/0

2879784bcb8-ydn91.cn-guangzhou.nas.aliyuncs.com:/ 10P 0 10P 0% /mnt

#自动添加到自动挂载

[root@iZ7xvir6mu3v4yxtwwtiw6Z /mnt]#cat /etc/fstab

#

# /etc/fstab

# Created by anaconda on Fri Jun 28 04:16:23 2024

#

# Accessible filesystems, by reference, are maintained under '/dev/disk'

# See man pages fstab(5), findfs(8), mount(8) and/or blkid(8) for more info

#

UUID=c8b5b2da-5565-4dc1-b002-2a8b07573e22 / ext4 defaults 1 1

2879784bcb8-ydn91.cn-guangzhou.nas.aliyuncs.com:/ /mnt nfs vers=3,nolock,proto=tcp,rsize=1048576,wsize=1048576,hard,timeo=600,retrans=2,noresvport,_netdev 0 0

#创建文件

[root@iZ7xv5bq4vfmj0398fehyiZ /mnt]#touch {1..10}.log

[root@iZ7xv5bq4vfmj0398fehyiZ /mnt]#ll

total 0

-rw-r--r-- 1 root root 0 Apr 25 14:27 10.log

-rw-r--r-- 1 root root 0 Apr 25 14:27 1.log

-rw-r--r-- 1 root root 0 Apr 25 14:27 2.log

-rw-r--r-- 1 root root 0 Apr 25 14:27 3.log

-rw-r--r-- 1 root root 0 Apr 25 14:27 4.log

-rw-r--r-- 1 root root 0 Apr 25 14:27 5.log

-rw-r--r-- 1 root root 0 Apr 25 14:27 6.log

-rw-r--r-- 1 root root 0 Apr 25 14:27 7.log

-rw-r--r-- 1 root root 0 Apr 25 14:27 8.log

-rw-r--r-- 1 root root 0 Apr 25 14:27 9.log

2、卸载

bash[root@iZ7xv5bq4vfmj0398fehyiZ /]#df -h

Filesystem Size Used Avail Use% Mounted on

devtmpfs 485M 0 485M 0% /dev

tmpfs 496M 0 496M 0% /dev/shm

tmpfs 496M 520K 495M 1% /run

tmpfs 496M 0 496M 0% /sys/fs/cgroup

/dev/vda1 40G 3.1G 35G 9% /

tmpfs 100M 0 100M 0% /run/user/0

# 卸载后挂载到别的云服务器,文件照样存在

[root@iZ7xv58a45kz3zmvjl2vajZ ~]#cd /mnt

[root@iZ7xv58a45kz3zmvjl2vajZ /mnt]#ll

total 0

-rw-r--r-- 1 root root 0 Jun 12 18:53 10.log

-rw-r--r-- 1 root root 0 Jun 12 18:53 1.log

-rw-r--r-- 1 root root 0 Jun 12 18:53 2.log

-rw-r--r-- 1 root root 0 Jun 12 18:53 3.log

-rw-r--r-- 1 root root 0 Jun 12 18:53 4.log

-rw-r--r-- 1 root root 0 Jun 12 18:53 5.log

-rw-r--r-- 1 root root 0 Jun 12 18:53 6.log

-rw-r--r-- 1 root root 0 Jun 12 18:53 7.log

-rw-r--r-- 1 root root 0 Jun 12 18:53 8.log

-rw-r--r-- 1 root root 0 Jun 12 18:53 9.log

10、OSS

bashOSS对象存储 15.1) 什么是对象存储? 阿里云对象存储OSS(Object Storage Service)是一款海量、安全、低成本、高可靠的云存储服务,可提供99.9999999999%(12个9)的数据持久 性,99.995%的数据可用性。多种存储类型供选择,全面优化存储成本。 OSS具有与平台无关的RESTful API接口,您可以在任何应用、任何时间、任何地点存储和访问任意类型的数据。 15.2) 对象存储使用场景? 15.3) Kodcloud对接OSS存储构建私有网盘 Document:https://help.aliyun.com/product/31815.html?spm=a2c4g.11186623.6.540.152f406cjmJWuA

bash用户想访问图片,正常访问流程通过负载均衡代理着用户访问到程序框架,然后才能访问到nfs的图片。 如果是oss,用户通过cdn加速可以直接访问,免去了走程序框架

1、购买

bash1.创建bucket

2、kod介入oss

bash2.创建子账号获取信息 进入bucket-->权限控制-->访问控制RAM-->前往RAM控制台--用户:创建用户

bash用户登录名称:weixiang@1431044874515527.onaliyun.com AccessKey ID:LTAI5tPb7SQjbizHNhYC3AzJ AccessKey Secret:qHqm5jgunyfRAnkmh2nHLCSLdlZYVQ

bash给账号添加管理存储的权限:

权限控制-->bucket授权策略-->新增授权,授权子账号拥有完全控制权限

#ping以下看看地域节点通不通

[root@iZ7xv5bq4vfmj0398fehyiZ /]# ping oss-cn-guangzhou-internal.aliyuncs.com

PING oss-cn-guangzhou-internal.aliyuncs.com (100.115.33.42) 56(84) bytes of data.

64 bytes from 100.115.33.42 (100.115.33.42): icmp_seq=1 ttl=102 time=0.129 ms

64 bytes from 100.115.33.42 (100.115.33.42): icmp_seq=2 ttl=102 time=0.140 ms

bash3.根据上面信息对接kod云平台

3、删除oss

11、CDN

bash什么是CDN? 内容分发网络 面试题: cdn加速原理 我们在北京要访问上海的网站,因为跨网络特别远,怎么样提高效率呢,当然要访问离我们最近的服务器,正好昌平有个机房里面有大量的服务器,这个 机房存储着要访问的资源,所以我们访问的内容在这个机房就可以给我们响应了,不需要跨区域再去上海访问,每个地区都有CDN节点,目的就说为了提高 用户访问静态资源的速度

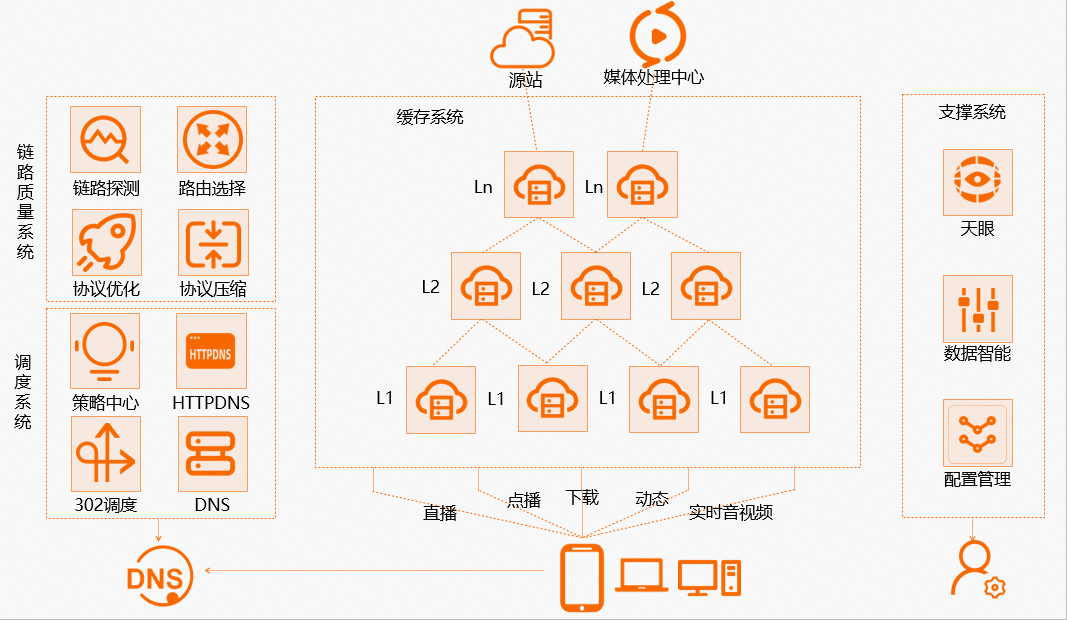

1、产品架构

bash当用户去访问静态资源的时候,会先去访问DNS,DNS拿到CNAME,会进入智能DNS,会进行链路探测,判断你带宽的来源,比如移动,之后会进行一个路 由选择,然后再进行一个策略中心调度,会给用户返回最近的一个CDN节点。如果返回给用户没有目标资源,会向二级缓存请求,如果全没有会去访问源站, 从源站拿到资源后会给所以的CDN节点加载资源,然后再响应给用户

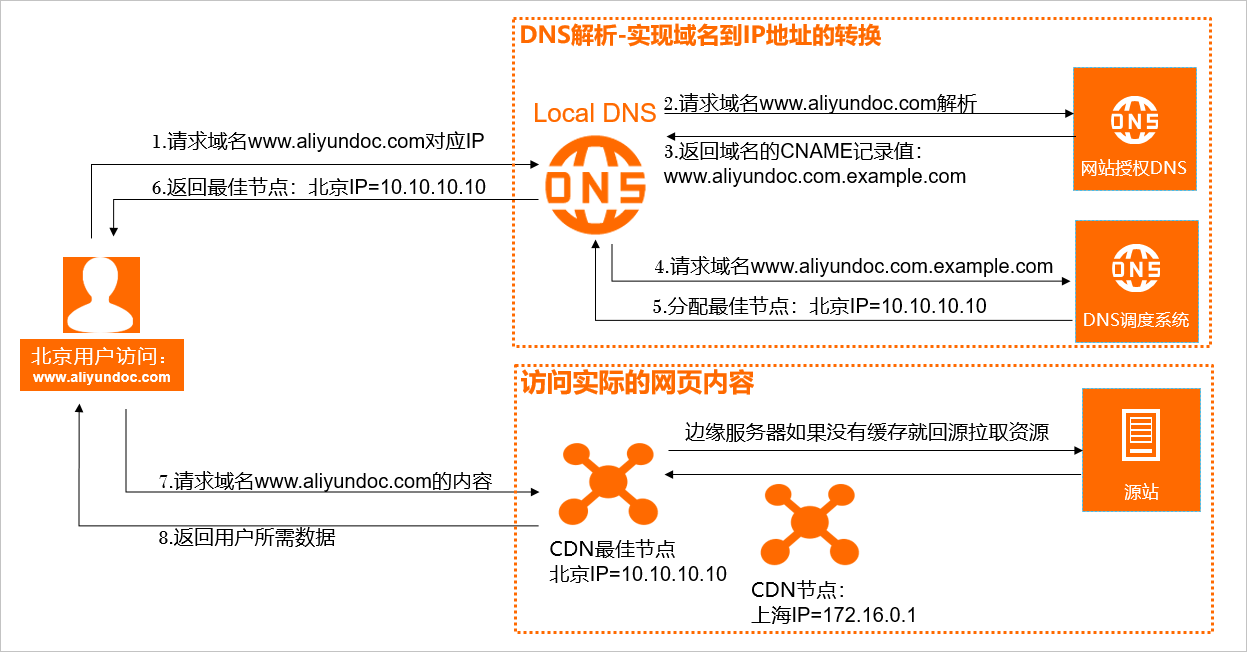

2、加速原理

bash1.当终端用户向www.aliyundoc.com下的指定资源发起请求时,首先向Local DNS(本地DNS)发起请求域名www.aliyundoc.com对应的IP。 2.Local DNS检查缓存中是否有www.aliyundoc.com的IP地址记录。如果有,则直接返回给终端用户;如果没有,则向网站授权DNS请求域名www.aliyundoc.com的解析记录。 3.当网站授权DNS解析www.aliyundoc.com后,返回域名的CNAME www.aliyundoc.com.example.com。 4.Local DNS向阿里云CDN的DNS调度系统请求域名www.aliyundoc.com.example.com的解析记录,阿里云CDN的DNS调度系统将为其分配最佳节点IP地址。 5.Local DNS获取阿里云CDN的DNS调度系统返回的最佳节点IP地址。 6.Local DNS将最佳节点IP地址返回给用户,用户获取到最佳节点IP地址。 7.用户向最佳节点IP地址发起对该资源的访问请求。

3、CDN概述

bash配置CDN场景

1.简单的验证: 先搭建一个可道云,然后检测是否丛源站获取资源,然后配置加速,在验证是否丛不同的CDN节点获取的资源.

2.分布式缓存:源站提供mp4下载,然后通过不同地域的服务器wget资源,检查是否是从不同地域的边缘节点获取的资源。

3.检测的站点 ( http://tool.chinaz.com/speedtest.aspx | https://tools.ipip.net/ping.php )

#加CDN前

bash#新上传图片测试,显示公网负载均衡地址

4、部署CDN

bash1.添加域名:

CDN-域名管理-添加域名 #此时要用备案的域名

加速域名,业务类型,新增源站信息

bash2.配置CNAME

将域名解析到CNAME记录值

DNS-解析设置,将记录类型A改为CNAME,记录纸的值从公网ip改为CNAME的值

#测试,ping以下公网ip,正确是返回CDNDE IP地址,只要不是返回自己的公网ip

#站点测试tools.ipip.net/ping.php

bash可以看到已经返回cdn的节点了

``·

bash#故障案例

公司开发上传了一张图片,但是客户那边没变,排查问题发现前端加了cdn,根据cdn机制,cdn有就响应,没有就去源站请求

CDN缓存机制:

上传/code目录第二张图片覆盖第一张,用户请求域名会先去请求cdn,cdn会根据名称进行返回,如果查询的名字一样,那cdn就返回第一张图片内容

解决方法:

一、刷新:给后台一个链接,比如kod.linux.com/123.png对这个链接进行刷新,删除所有cdn节点上的资源,重新去请求源站,获取123.png,强制回源

二、预热:提前把资源上传到cdn节点预热,全国各地所有cdn节点就有了,就不用回源

操作方法:CDN-刷新,放置新图片链接-提交,浏览器测试是否更换成新图片

删除CDN后要把记录类型修改成A,记录纸修改为CNAME

12、WAF防火墙

bashhttps://yunsuo.qianxin.com/

应用层面防火墙

1.下载

[root@web01 ~]#wget https://download.yunsuo.qianxin.com/v3/yunsuo_agent_64bit.tar.gz && tar xvzf yunsuo_agent_64bit.tar.gz && chmod +x yunsuo_install/install && yunsuo_install/install

2.注册用户

bash3.默认已经启动

[root@web01 ~]#ps aux|grep yunsuo

root 21821 0.1 3.3 1728580 59904 ? Sl 08:30 0:00 ./yunsuo_agent_service -c config.xml -l runlog/run_log.log -e ALL -t ALL -s safe -m daemon

root 21892 0.0 0.2 175704 4848 ? Ssl 08:30 0:00 ./yunsuo_agent_guard

root 21986 0.0 0.0 112812 976 pts/0 S+ 08:36 0:00 grep --color=auto yunsuo

4.添加服务器到云中心。

[root@web01 ~]#/usr/local/yunsuo_agent/agent_smart_tool.sh -u 1360821977@qq.com -p weixiang123

Bind Server Success.

5.云锁启动/停止/重启/状态

service yunsuo start/stop/restart/status

/etc/init.d/yunsuo start/stop/restart/status

6./usr/local/yunsuo_agent/uninstall

#下载windows版本云锁

云锁实现的功能:

抗CC攻击:秒级识别恶意流量,保障网站可用性

防篡改:实时监控网页,拦截暗链、黑链、挂马

防御SQL注入、禁用敏感词

展示CPU、内存、磁盘、网络IO等性能指标,支持阈值告警

#面试题

做过安全吗?

我在上家公司主要是维护web服务器这一块,安全这一块虽然不是我具体负责,但我知道我们公司关于安全的业务是怎么做的

1.首先是网络层面的一个控制,前面硬件的话有硬件防火墙,是网络安全方面的一个防护,在硬件防火墙里面开启防cc攻击,防洪水、syn攻击。这些我都配置过

2.系统层面,修改默认SSH,默认端口,禁止默认root登录,使用普通用户提权登录,配置iptables规则放行80跟443端口还有远程连接的端口,阿里云(安全组规则)

3.业务层面安全,因为我上面是web服务器,前面部署开源云锁WAF防火墙,防文件篡改,防用户连接跟请求

13、弹性伸缩

1、什么是弹性伸缩

bash13.1) 什么是弹性伸缩? 使用弹性伸缩(Auto Scaling),您可以根据业务需求和策略设置伸缩规则,在业务需求增长时自动为您增加ECS实例以保证计算能力,在业务需求下降时自动减少ECS实例以节约成本。弹性伸缩不仅适合业务量不断波动的应用程序,同时也适合业务量稳定的应用程序。 13.2) 弹性伸缩应用场景 某视频公司:春晚或每周五热门节目来临时,负载激增,需及时、自动扩展云计算资源。 某视频直播公司:业务负载变化难以预测,需要阿里云自动根据CPU利用率、应用负载、带宽利用率作为衡量指标进行弹性伸缩。 某游戏公司:每天中午12点及晚上6点到9点间需求增长,需要定时扩容。 某电商:在大促中,临时激增大量云服务器需求,需要在数分钟内实现从创建到可用。 13.3) 弹性伸缩模式 定时模式:您自定义自动伸缩发生的时间和频率,如每天 13:00增加 ECS 实例。 动态模式:基于云监控性能指标(如 CPU 利用率),自动增加或减少 ECS 实例。 健康模式:如 ECS 实例为非 Running 状态,弹性伸缩将自动移出或释放不健康的 ECS 实例。 13.4) ESS弹性伸缩配置实践 配置的流程: 配置好负载均衡-->创建伸缩组-->添加伸缩配置-->添加已有ECS实例-->启用伸缩组 1) 创建伸缩组规则 1.1) 添加ECS实例规则 CPU大于80% 1.2) 减少ECS实例规则 CPU小于30% 2) 弹性伸缩规则会在什么时候添加或减少,根据动作来触发. 定时任务 云上监控 3) 模拟CPU大于百分之80% Document:https://help.aliyun.com/product/25855.html?spm=a2c4g.11186623.6.540.535448595bgK6Y

2、创建弹性伸缩

bash#1.创建弹性伸缩:

弹性伸缩-伸缩组管理-创建伸缩组

注意点:1.组内实例配置信息来源,选择某个实例当模板来配置伸缩实例

2.添加已有实例,把原先存在的都勾选上

3.关联传统型负载均衡CLB(原SLB),要选中才能把新加入的添加到负载均衡里

bash#2.配置伸缩规则

弹性伸缩-伸缩组管理-伸缩规则与报警任务-创建伸缩规则

注意点:创建报警任务,根据业务选择不同的报警指标描述,如系统平均负载、内存、cpu使用率等,重复几次后报警

执行操作、实际预热时间

bash#3.执行测试任务

1.负载均衡配置四层负载,xshell连接两台虚拟机

2.安装ab命令

[root@iZ7xv00d8xv6isvthuiz7aZ ~]#yum -y install httpd

3.两台web都执行压力测试

[root@iZ7xv00d8xv6isvthuiz7bZ ~]#ab -n200000 -c200 http://127.0.0.1/index.php

4.xshell登录另一个窗口,监控负载

[root@iZ7xv00d8xv6isvthuiz7bZ ~]#uptime

17:40:56 up 31 min, 3 users, load average: 19.97, 5.01, 1.71

#测试,已自动扩展两台至四台

3、报错案例

bash案例:安装过程中出现弹性伸缩-报警任务-系统监控出现数据不足的状态

bash如果是上图这样,那么这个问题是因为ECS服务器中没有安装云监控插件, 或者是安装了云监控插件,但是因为网络问题,导致云监控插件没有成功上报数据给云监控平台,导致 云监控平台 获取不到服务器的采集数据,就会显示数据不足,麻烦您点这里https://cloudmonitor.console.aliyun.com/hostMonitor/?AliyunHost=all&KeyWord=name,¤tPage=1&pageSize=10 然后如下图去安装更新下云监控后等10分钟后测试下,谢谢。 https://help.aliyun.com/document_detail/183482.html

4、缩减弹性伸缩

bash弹性伸缩-伸缩组管理-伸缩规则与报警任务-创建伸缩规则

注意点:报警指标描述:系统平均负载要选<

执行操作要选减少

#测试

14、NATA

1、概念

bash14.NAT(运维) 14.1) 内网ECS没有购买公网IP,无法上网 方式一、firewalld实现内部主机共享上网(不推荐) 1.购买一台ECS专门用于共享上网,需要有独立公网IP,主机名称为Manager 2.开启Manager服务器firewalld防火墙,打开masquerade路由转发功能 3.找到需要上网的ECS实例所在的VPC网络,添加一条路由规则,去往0.0.0.0/0 下一跳是Manager 这台ECS实例 方式二、NAT网关实现内网共享上网 (强烈推荐) 1.购买按量付费的NAT网关 2.购买弹性EIP,将EIP捆绑置NAT网关 3.配置NAT网关的SNAT路由条目,进行地址转换,最后测试连通性 注意: NAT网关设备允许多个可用区共用一个NAT网关设备进行上网 Document:https://help.aliyun.com/product/44413.html?spm=a2c4g.11186623.6.540.47462f2aoaZFjK 14.2)解决内网主机无法直连的问题 方式一、跳板机方式 方式二、负载均衡TCP 方式三、NAT网关端口映射( 需要额外在购买一个弹性公网IP地址 )

2、设置NAT

bash1.阿里云没有内网,上不去网

[root@iZ7xv00d8xv6isvthuiz7bZ ~]#ping www.baidu.com

PING www.a.shifen.com (183.2.172.177) 56(84) bytes of data.

^C

--- www.a.shifen.com ping statistics ---

3 packets transmitted, 0 received, 100% packet loss, time 1999ms

2.配置NAT网关

NAT网关-创建公网NAT-购买,需要绑定弹性公网ip

注意:访问模式选择稍后设置

公网NAT网关-设置SNAT-创建SNAT条目(会出现VPC粒度、交换机粒度、ESC/弹性网卡粒度、自定义网段粒度)-选择VPC粒度

VPC粒度:所有地域下的都能上网,比如呼和浩特

交换机粒度:在本交换机下面的都可以上网

ESC/弹性网卡粒度:自己选择谁可以上网

自定义网段粒度:只允许哪个网段可以上网

bash3.再ping测试可以通

[root@iZ7xv00d8xv6isvthuiz7bZ ~]#ping www.baidu.com

PING www.a.shifen.com (183.2.172.177) 56(84) bytes of data.

64 bytes from 183.2.172.177 (183.2.172.177): icmp_seq=1 ttl=50 time=4.78 ms

64 bytes from 183.2.172.177 (183.2.172.177): icmp_seq=2 ttl=50 time=4.71 ms

[root@iZ7xv00d8xv6isvthuiz7aZ ~]#curl cip.cc

IP : 8.134.171.158

地址 : 中国 广东 广州

运营商 : 阿里云

数据二 : 中国广东深圳 | 阿里云

数据三 : 中国 | 阿里巴巴

URL : http://www.cip.cc/8.134.171.158

创建DNAT管理,不需要通过负载均衡

专有网-公网NAT网关-ngw-7xvnli6ai79ia056oz75r-创建DNAT条目

bash#测试可以连接

[C:\~]$ ssh 8.134.88.105 111

Connecting to 8.134.88.105:111...

Connection established.

To escape to local shell, press 'Ctrl+Alt+]'.

WARNING! The remote SSH server rejected X11 forwarding request.

Last failed login: Thu Jun 12 22:02:55 CST 2025 from 219.77.222.7 on ssh:notty

There were 8 failed login attempts since the last successful login.

Last login: Thu Jun 12 18:52:36 2025 from 123.117.19.236

Welcome to Alibaba Cloud Elastic Compute Service !

3、VPC NAT网关

bash实现不同地域之间的网络连接 VPC NAT网关(VPC NAT Gateway)是一款企业级的VPC私网网关,提供私网NAT代理(SNAT和DNAT),可支持VPC和线下IDC及VPC之间地址转换 能力,可提供高达100Gbps转发能力以及跨可用区容灾能力。

15、Ansible

1、Ansible安装配置

bash基本概述:

Ansible是一个自动化统一配置管理工具,自动化主要体现在Ansible集成了丰富模块以及功能组件,可以通过一个命令完成一系列操作,

从而减少重复性的工作和维护成本,可以提高工作效率

#1.在python安装源码包

[root@m01 ~]#wget https://www.python.org/ftp/python/3.8.16/Python-3.8.16.tgz

#2.解压

[root@m01 ~]#tar xzf Python-3.8.16.tgz

#3.进入

[root@m01 ~]#cd Python-3.8.16

#4.编译

[root@m01 ~/Python-3.8.16]#./configure --enable-optimizations

[root@m01 ~/Python-3.8.16]#make -j$(nproc)

[root@m01 ~/Python-3.8.16]#make altinstall

#5.安装Ansible

[root@m01 ~/Python-3.8.16]#pip3.8 install ansible

[root@m01 ~]#ansible --version

ansible [core 2.13.13]

#6.配置ansible (不需要启动)

[root@m01 ~/Python-3.8.16]#mkdir /etc/ansible

[root@m01 ~/Python-3.8.16]#vim /etc/ansible/ansible.cfg

[defaults]

host_key_checking = False

deprecation_warnings = False

interpreter_python = /usr/bin/python3

[inventory] #如果不写就按照编译的默认配置

[privilege_escalation]

[paramiko_connection]

[ssh_connection]

[persistent_connection]

[accelerate]

[selinux]

[colors]

[diff]

1、Ansible使用

bash#ansible <host-pattern> [options]

--version #ansible版本信息

-v #显示详细信息

-i #主机清单文件路径,默认是在/etc/ansible/host

-m #使用模块名称,默认使用command模块

-a #使用的模块参数,模块的具体动作

-k #提示输入ssh密码,而不使用基于ssh的密钥认证

-C #模拟执行测试,但不会真的执行

-T #执行命令的超时

2、Ansible主机清单

bash#配置方式有两种,一种基于用户名密码的方式管理客户端,一种基于免秘钥的方式管理客户端

方法1.基于用户名密码方式管理客户端

[root@m01 ~]#cat /etc/ansible/hosts

172.16.1.7 ansible_ssh_user=root ansible_ssh_port=22 ansible_ssh_pass='Sdms2018'

✦•············································································································•✦

分割线

✦•············································································································•✦方法2.基于免秘钥方式管理客户端(使用此方式管理客户端)

#单台配置

#1.配置文件

[root@m01 ~]#cat /etc/ansible/hosts

172.16.1.7

172.16.1.8

#2.创建密钥

[root@m01 ~]#ssh-keygen

Generating public/private rsa key pair.

Enter file in which to save the key (/root/.ssh/id_rsa):

Enter passphrase (empty for no passphrase):

Enter same passphrase again:

Your identification has been saved in /root/.ssh/id_rsa

Your public key has been saved in /root/.ssh/id_rsa.pub

The key fingerprint is:

SHA256:fxMERq7conAFXpHG0SujhmY8GvdjM90lOEiXNokYMuQ root@m01

The keys randomart image is:

+---[RSA 3072]----+

| .. ..+*+ |

| .o .. o+o.. |

| Eo o.o.o... |

| . ooOo.. |

| ..o.=S=. . |

| . Bo+.oo. .. |

| * +.. o.oo |

| . * . .. . |

| . + |

+----[SHA256]-----+

#3.钥匙复制到7、8

[root@m01 ~]#ssh-copy-id 172.16.1.7

[root@m01 ~]#ssh-copy-id 172.16.1.8

#4.ping测试

[root@m01 ~]#ansible all -m ping

172.16.1.7 | SUCCESS => {

"changed": false,

"ping": "pong"

}

172.16.1.8 | SUCCESS => {

"changed": false,

"ping": "pong"

}

注意:

#如果修改成这种方式,只能写前面的主机名称,写ip报错

[root@m01 ~]#cat /etc/ansible/hosts

web01 ansible_ssh_host=172.16.1.7

web02 ansible_ssh_host=172.16.1.8

[root@m01 ~]#ansible web01 -m ping

web01 | SUCCESS => {

"changed": false,

"ping": "pong"

}

[root@m01 ~]#ansible 172.16.1.7 -m ping

[WARNING]: Could not match supplied host pattern, ignoring: 172.16.1.7

[WARNING]: No hosts matched, nothing to do

#Ansible主机清单设置组

[root@m01 ~]#ansible web_server -m ping

172.16.1.8 | SUCCESS => {

"changed": false,

"ping": "pong"

}

172.16.1.7 | SUCCESS => {

"changed": false,

"ping": "pong"

}

#定义多组,多组汇总整合

[root@m01 ~]#cat /etc/ansible/hosts

[db_server]

172.16.1.51

[web_server]

172.16.1.7

172.16.1.8

[root@m01 ~]#ansible db_server -m ping

172.16.1.51 | SUCCESS => {

"changed": false,

"ping": "pong"

}

#hehe这个组包含了db_server、web_server,操作hehe就等于操作这两个组

[root@m01 ~]#cat /etc/ansible/hosts

[db_server]

172.16.1.51

[web_server]

172.16.1.7

172.16.1.8

[hehe:children]

db_server

web_server

[root@m01 ~]#ansible hehe -m ping

172.16.1.51 | SUCCESS => {

"changed": false,

"ping": "pong"

}

172.16.1.8 | SUCCESS => {

"changed": false,

"ping": "pong"

}

172.16.1.7 | SUCCESS => {

"changed": false,

"ping": "pong"

}

[root@m01 ~]#ansible web_server -m ping

[root@m01 ~]#cat /etc/ansible/hosts

[web_server:vars]

ansible_ssh_user=root

ansible_ssh_pass='Sdms2018'

#使用变量

172.16.1.8 | SUCCESS => {

"changed": false,

"ping": "pong"

}

1、Ansible示例

bash[root@m01 ~]#ansible-doc yum

EXAMPLES:

- name: Install the latest version of Apache

ansible.builtin.yum:

name: httpd 👉 #软件名字

state: latest 👉 #状态,最新版本,很少安装最新版本

- name: Install Apache >= 2.4

ansible.builtin.yum:

name: httpd>=2.4

state: present 👉 #状态安装

- name: Remove the Apache package

ansible.builtin.yum:

name: httpd 👉 #软件名字

state: absent 👉 #状态卸载

EXAMPLES:

- name: Copy file with owner and permissions

ansible.builtin.copy:

src: /srv/myfiles/foo.conf 👉 #原文件

dest: /etc/foo.conf 👉 #目标位置

owner: foo 👉 #属主

group: foo 👉 #属组

mode: '0644' 👉 #权限

2、知识点小结

bash知识点小结:

1.ansible安装 python3.8安装 创建配置文件(/etc/ansible/ansible.cfg)

mkdir /etc/ansible

vim /etc/ansible/ansible.cfg

粘贴配置...

-----------远程管理客户端方式

2.基于ip+端口+用户名+密码远程验证方式(使用较少)

vim /etc/ansible/hosts

172.16.1.7 ansible_ssh_user=root ansible_ssh_pass='oldboy123.com'

3.基于免秘钥方式配置主机清单

1)生产密钥对

2)和客户端做免秘钥

ssh-copy-id 172.16.1.7

3)vim /etc/ansible/hosts

web01 ansible_ssh_host=172.16.1.7

-----------------------------

4.主机清单配置方式

支持单台

172.16.1.7

172.16.1.8

支持组

[web_server]

172.16.1.7

172.16.1.8

[db_server]

172.16.1.51

支持多个组的组合

[lnmp:children]

web_server

db_server

3、Ansible-adhoc

bash#Ad-hoc部署backup服务

#1.41拷贝rsyncd.conf到61

[root@backup /]#scp -r /etc/rsyncd.conf 10.0.0.61:/root/

#2.配置

[root@m01 ~/.ssh]#cat /etc/ansible/hosts

[backup_server]

backup ansible_ssh_host:172.16.1.41

#3.61免密钥到41

[root@m01 ~]#ssh-copy-id 172.16.1.41

#4.执行安装步骤

使用yum模块安装rsync服务

#安装rsync服务

[root@m01 ~]#ansible backup -m yum -a 'name=rsync state=present'

-m: #模块,必有

-a: #动作,必有

name=rsync: #软件名字rsync

state=present: #state动作,present安装

#5.配置Rsync服务,将61服务器./rsyncd.conf拷贝到/etc/下

[root@m01 ~]#ansible backup -m copy -a 'src=./rsyncd.conf dest=/etc/'

#6.根据配置文件创建必要的数据信息

与 Playbook 的对比:

| 特性 | Ad-Hoc 命令 | Playbook |

|---|---|---|

| 复杂度 | 简单(单条命令) | 复杂(YAML 文件) |

| 适用场景 | 临时任务、快速验证 | 复杂流程、重复性任务 |

| 可复用性 | 不可复用 | 可版本控制、重复使用 |

| 功能完整性 | 功能受限(不支持条件/循环等逻辑) | 支持完整自动化逻辑 |

| 执行日志 | 无持久化记录 | 有详细执行记录 |

1、ping模块

bash#模块1.ping模块 测试联通性,不指定文件位置会默认。

[root@m01 ~]#ansible web_server -m ping

172.16.1.7 | SUCCESS => {

"changed": false,

"ping": "pong"

}

172.16.1.8 | SUCCESS => {

"changed": false,

"ping": "pong"

}

#2.ping模块 测试联通性,-i 指定文件位置

cp /etc/ansible/hosts ./zhang

[root@m01 ~]#ansible all -m ping -i zhang/hosts

backup | SUCCESS => {

"changed": false,

"ping": "pong"

}

172.16.1.51 | SUCCESS => {

"changed": false,

"ping": "pong"

}

172.16.1.8 | SUCCESS => {

"changed": false,

"ping": "pong"

}

172.16.1.7 | SUCCESS => {

"changed": false,

"ping": "pong"

}

2、yum模块

bashyum:

-m: #模块,必有

-a: #动作,必有

name: lrzsz # 软件名称可以是本地的rpm包

state: present|absent # 安装或者卸载

latest # 安装最新版本

download_only: true # 只下载不安装

download_dir: /opt/ # 只下载不安装存放的位置

#卸载41的lrzsz,黄色表示已经卸载完成

[root@m01 ~]#ansible backup -m yum -a 'name=lrzsz state=absent'

backup | CHANGED => {

"ansible_facts": {

"pkg_mgr": "dnf"

},

"changed": true,

"msg": "",

"rc": 0,

"results": [

"Removed: lrzsz-0.12.20-46.ky10.x86_64"

]

}

#查看41,已经没有了

[root@backup /]#sz

-bash: sz: command not found

[root@backup /]#rz

-bash: rz: command not found

#同时卸载web01和web02的wget

[root@m01 ~]#ansible web_server -m yum -a "name=wget state=absent"

#安装

[root@m01 ~]#ansible web_server -m yum -a "name=wget state=present"

3、copy模块

bashcopy:

src: /etc/passwd # 指定源文件的位置 content

dest: /root/

owner: www

group: www

mode: 0600

backup: yes

#案例1.将61服务器/etc/passwd拷贝到41服务器/root/下并修改属主属组为www,修改权限为600

[root@m01 ~]#ansible backup -m copy -a 'src=/etc/passwd dest=/root/ owner=www group=www mode=600'

查看

[root@backup ~]#ll

-rw------- 1 www www 1927 Apr 27 21:36 passwd

#案例2.拷贝hosts到root目录下改名为1.txt

[root@m01 ~]#ansible backup_server -m copy -a 'src=/etc/hosts dest=/root/1.txt'

backup | CHANGED => {

"changed": true,

"checksum": "7335999eb54c15c67566186bdfc46f64e0d5a1aa",

"dest": "/root/1.txt",

"gid": 0,

"group": "root",

"md5sum": "54fb6627dbaa37721048e4549db3224d",

"mode": "0644",

"owner": "root",

"size": 158,

"src": "/root/.ansible/tmp/ansible-tmp-1745817736.6964135-76073-247149860659350/source",

"state": "file",

"uid": 0

}

#案例3.拷贝目录

[root@m01 ~]#ansible backup_server -m copy -a 'src=zhang dest=/root/'

backup | CHANGED => {

"changed": true,

"dest": "/root/",

"src": "/root/zhang"

}

#案例4.目标文件是否备份使用backup参数,如果目标文件存在

#当源文件(src)与目标文件(dest)同名且内容不同时,Ansible会先将原始文件重命名为备份文件,然后再复制新文件,不会覆盖原文件

[root@m01 ~]#ansible backup_server -m copy -a 'src=1 dest=/root backup=yes'

backup | CHANGED => {

"backup_file": "/root/1.73259.2025-04-28@13:28:16~", 👉 #目录名称

"changed": true,

"checksum": "4183845ea9681da0328a776c957ea1ada6e6190c",

"dest": "/root/1",

"gid": 0,

"group": "root",

"md5sum": "c5f42eddf777ef2d2b0f7263c094c20f",

"mode": "0644",

"owner": "root",

"size": 8,

"src": "/root/.ansible/tmp/ansible-tmp-1745818095.5799327-76209-222995593520644/source",

"state": "file",

"uid": 0

}

#案例5.将100定向到目标主机/root/100.log下,源目录没有也会自动创建,将content的100定向到100.log

[root@m01 ~]#ansible backup_server -m copy -a 'content=100 dest=/root/100.log'

[root@backup ~]#cat 100.log

100

#案例6.将content后面的字符串定向到目标主机的pass.txt中 权限为600

[root@m01 ~]#ansible backup_server -m copy -a 'content=100 dest=/root/100.log'

[root@m01 ~]#ansible backup -m copy -a 'content="rsync_backup:123456" dest=/root/pass.txt mode=0600'

4、command模块

bash#后面直接加命令,缺乏shell环境,管道等符号不支持,不建议使用

#案例1.创建文件

[root@m01 ~]#ansible backup_server -m command -a 'touch /root/1.log'

backup | CHANGED | rc=0 >>

[root@backup ~]#ll

total 0

-rw-r--r-- 1 root root 0 Apr 28 13:53 1.log

#案例2.下载命令

[root@m01 ~]#ansible backup_server -m command -a 'yum -y install lrzsz'

5、file模块

bashfile:

path: /root/a.txt 👉 # 路径

state: touch 👉 # 创建文件

directory 👉 # 创建目录

owner: www

group: www

mode: 0600

recurse: yes 👉 # 递归修改目录及以下所有文件属主属组

#案例1.创建a.txt 属主属组为lp 权限为600

[root@m01 ~]#ansible backup_server -m file -a 'path=/root/a.txt state=touch owner=www group=www mode=600'

[root@backup ~]#ll

total 0

-rw------- 1 www www 0 Apr 28 14:02 a.txt

#案例2.创建oldboy目录 属主属组为root权限给777

[root@m01 ~]#ansible backup_server -m file -a 'path=/root/oldboy state=directory mode=777'

drwxrwxrwx 2 root root 6 Apr 28 14:04 oldboy

#案例3.递归创建目录

[root@m01 ~]#ansible backup_server -m file -a 'path=/root/1/2/3 state=directory mode=777'

[root@backup ~]#tree 1

1

└── 2

└── 3

#案例4.递归修改文件的属主属组

[root@m01 ~]#ansible backup_server -m file -a 'path=/root/1 state=directory owner=www group=www recurse=yes'

#案例5.删除文件a.txt

[root@m01 ~]#ansible backup_server -m file -a 'path=/root/a.txt state=absent'

#案例6.删除目录1,递归删除

[root@m01 ~]#ansible backup_server -m file -a 'path=/root/1 state=absent'

6、group模块

bash#案例1.创建一个组 gid为666 名称为www

[root@m01 ~]#ansible backup -m group -a 'name=www gid=666 state=present'

#查看

[root@backup ~]#grep www /etc/group

www:x:666:

7、user模块

bashuser:

name: www

uid: 666

group: www

shell: /bin/bash 或者/sbin/nologin

state: present 👉 # 创建用户

absent 👉 # 删除用户

remove: yes 👉 # 删除用户所有相关信息

create_home: true 👉 # 创建家目录 默认为true

false 👉 # 不创建家目录 创建虚拟用户的时候使用

#案例1.创建一个普通账号hehe uid300 gid300 创建家目录 允许登录

先创建组

[root@m01 ~]#ansible backup_server -m group -a 'name=hehe gid=300 state=present'

再创建用户

[root@m01 ~]#ansible backup_server -m user -a 'name=hehe uid=300 group=300 create_home=true shell=/bin/bash'

#案例2.创建一个虚拟账号 oldboy uid 777 gid 777 不创建加 不允许登录

[root@m01 ~]#ansible backup_server -m group -a 'name=oldboy gid=777 state=present'

[root@m01 ~]#ansible backup_server -m user -a 'name=oldboy uid=777 group=777 create_home=false shell=/sbin/nologin'

#案例3.删除用户oldboy,remove=yes参数的作用是彻底删除用户及其关联的目录和文件

[root@m01 ~]#ansible backup_server -m user -a 'name=oldboy state=absent remove=yes'

8、yum_repository模块

bashvim /etc/yum/repos.d/nginx.repo

[nginx-stable] 👉 # 名称

name=nginx stable repo 👉 # 名称描述

baseurl=http://nginx.org/packages/centos/7/$basearch/ 👉 # 下载的URL地址 通过此链接下载nginx软件

gpgcheck=1 👉 # 检查包的完整性 一般可以关闭

enabled=1 👉 # 1启动此仓库 0关闭此仓库

gpgkey=https://nginx.org/keys/nginx_signing.key 👉 # 检查的md5值

#如果系统时间对不上,gpgcheck开启的话没法检查包的完整性,无法正常下载,这时候可以把gpgcheck改为0

#案例: 部署nginx的仓库

[root@m01 ~]#ansible backup -m yum_repository -a 'name=nginx description="Nginx Repo" baseurl=http://nginx.org/packages/centos/7/$basearch/ gpgcheck=no enabled=yes'

#查看:

[root@backup ~]#cat /etc/yum.repos.d/nginx.repo

[nginx]

async = 1 #异步模式,允许并行下载

baseurl = http://nginx.org/packages/centos/7/$basearch/

enabled = 1

gpgcheck = 0

name = Nginx Repo

#下载测试,如果安装的是nginx是1.26,说明配置的nginx仓库正确

[root@m01 ~]#ansible backup_server -m yum -a 'name=nginx state=present'

[root@backup ~]#nginx -v

nginx version: nginx/1.26.1

9、systemd

bashsystemd:

name: nginx

state: started 👉 # 启动

stopped 👉 # 停止

restarted 👉 # 重启

reloaded 👉 # 重新加载

enable: yes 👉 # 开机自启 no 开机禁止启动

#案例1.启动nginx服务 并加入开机自启

[root@m01 ~]#ansible backup_server -m systemd -a 'name=nginx state=started enabled=yes'

#案例2.重启nginx服务

[root@m01 ~]#ansible backup_server -m systemd -a 'name=nginx state=restarted'

#案例3.重新加载nginx服务

[root@m01 ~]#ansible backup_server -m systemd -a 'name=nginx state=reloaded'

10、其他模块

bashsetup模块 #获取客户端所有的信息

setup 模块用于收集被管理节点(目标主机)的系统信息(Facts),这些信息以变量的形式存储,供Playbook或Ad-Hoc命令使用。

#案例1.获取IP地址

[root@m01 ~]#ansible backup -m setup -a 'filter=ansible_default_ipv4'

#案例2.获取内存信息

[root@m01 ~]#ansible backup -m setup -a 'filter=ansible_memory_mb'

#案例3.获取客户主机名称

[root@m01 ~]#ansible all -m setup -a 'filter=ansible_hostname'

或者

[root@m01 ~]#ansible all -m setup -a 'filter=ansible_fqdn'

bash内容总结:

1.ping模块

ansible web01 -m ping

2.yum模块

yum:

name: lrzsz 👉 # 安装软件的名称

state: 动作

present: 安装

absent: 卸载

ansible web01 -m yum -a 'name=lrzsz state=absent'

ansible web01 -m yum -a 'name=lrzsz state=present'

3.copy模块

copy:

src: /etc/hosts 👉 # ansible上的哪个文件

dest: /root 👉 # 存放客户端的具体路径

owner: lp 👉 # 属主

group: lp 👉 # 属组

mode: 0600 👉 # 文件权限

snible web01 -m copy -a 'src=/etc/hosts dest=/root/ onwer=lp group=lp mode=0600'

4、Ansible-playbook

bashPlayBook即“剧本”,“兵书”之意,由以下部分组成: play:定义的是主机的角色(主角还是配角,找哪个明星) task:定义的是具体执行的任务(角色的台词和动作) playbook:由一个或多个play(角色)组成,一个play(角色)可以包含多个task(台词,动作,大腕每集拍什么) 简单理解为,使用不同的模块完成一件事情

1、Playboot创建文件

bash1.书写Playboot

[root@m01 ~]#cat b.yml

- hosts: backup_server

tasks:

- name : backup touch a.txt 👉 #描述

file : 👉 #使用file模块

path: /root/a.txt 👉 #创建的路径

state: touch 👉 #动作

owner: root 👉 #属主

group: root 👉 #属组

mode: 0600 👉 #权限

- name : install nginx server

yum : 👉 #使用yum模块

name: nginx

state: present

2.检查语法

[root@m01 ~/ansible]#ansible-playbook --syntax-check b.yml

playbook: b.yml 👉 # 这样说明没问题

3.执行ansible

root@m01 ~]#ansible-playbook b.yml

PLAY [backup] ***********************************************************************************************

TASK [Gathering Facts] **************************************************************************************

ok: [backup] 👉 # 默认获取客户端信息

TASK [backup touch a.txt] ***********************************************************************************

changed: [backup]

TASK [install nginx server] *********************************************************************************

ok: [backup]

PLAY RECAP **************************************************************************************************

backup : ok=3 changed=1 unreachable=0 failed=0 skipped=0 rescued=0 ignored=0

4.查看

[root@backup ~]#ll

total 0

-rw-r--r-- 1 root root 0 Apr 28 13:53 1.log

-rw------- 1 root root 0 Apr 28 15:53 a.txt

2、Playbook重构backup服务

bash#1.配置主机清单

[root@m01 ~]#cat /etc/ansible/hosts

[backup_server]

backup ansible_ssh_host=172.16.1.41

#2.免秘钥,61发给41

[root@m01 ~]#ssh-copy-id 10.0.0.41

#3.写playbook

[root@m01 ~/ansible]#vim backup.yml

- hosts: backup_server

tasks:

- name: Install Rsyncd Server 👉 #1.安装rsync

yum:

name: rsync 🟢服务名

state: present 🟢安装

- name: configure Rsync Server 👉 #2.copy配置文件

copy:

src: rsyncd.conf 🟢源文件

dest: /etc/ 🟢目标位置

- name: Create Group www 👉 #3.创建属组

group:

name: www 🟢组名

gid: 666 🟢组id

- name: Create user www 👉 #4.创建用户

user:

name: www 🟢用户名

uid: 666 🟢用户id

group: www 🟢组名

shell: /sbin/nologin 🟢解释器

create_home: false 🟢创建家目录

- name: Create pass file 👉 #5.创建密码文件

copy:

content: rsync_backup:123

dest: /etc/rsync.passwd

mode: 0600 🟢权限

- name: Create /backup 👉 #6.创建目录

file:

path: /backup

state: directory

owner: www

group: www

- name: Start Rsync Server 👉 #7.开机自启

systemd:

name: rsyncd

state: started

enabled: yes

#4.根据内容创建数据

[root@m01 ~]#mkdir ansible

[root@m01 ~]#cp rsyncd.conf ansible/

#5.检查语法

[root@m01 ~/ansible]#ansible-playbook --syntax-check backup.yml

playbook: backup.yml

#6.执行

[root@m01 ~/ansible]#ansible-playbook backup.yml

#7.测试

[root@web01 ~]#rsync -avz /root/1.txt rsync_backup@10.0.0.41::backup

Password:

sending incremental file list

1.txt

sent 88 bytes received 43 bytes 87.33 bytes/sec

total size is 0 speedup is 0.00

3、Playbook重构NFS服务

1、安装配置NFS

bash#1.配置主机清单

[root@m01 ~/ansible]#cat /etc/ansible/hosts

[nfs_server]

nfs ansible_ssh_host=172.16.1.31

#2.免秘钥,61发给31

[root@m01 ~/ansible]#ssh-copy-id 172.16.1.31

#3.写playbook

[root@m01 ~/ansible]#cat nfs.yml

- hosts: nfs

tasks:

- name: Install nfs Server 👉 #1.安装nfs服务

yum:

name: nfs-utils

state: present

- name: Configure NFS Server 👉 #2.拷贝配置文件

copy:

src: exports

dest: /etc/

- name: Crete Group www 👉 #3.创建属组

group:

name: www

gid: 666

- name: Create user www 👉 #4.创建用户

user:

name: www

uid: 666

group: www

shell: /sbin/nologin

create_home: false

- name: Create /data/wp 👉 #5.创建路径

file:

path: /data/wp

state: directory

owner: www

group: www

- name: Start NFS Server 👉 #6.开机自启动

systemd:

name: nfs

state: started

enabled: yes

#4.根据内容创建数据

[root@m01 ~/ansible]#cat exports

/data/wp 172.16.1.0/24(rw,sync,all_squash,anonuid=666,anongid=666)

#5.语法检测

[root@m01 ~/ansible]#ansible-playbook --syntax-check nfs.yml

#6.执行playbook

[root@m01 ~/ansible]#ansible-playbook nfs.yml

PLAY [nfs] ***********************************************************************************************************************************************************************

TASK [Gathering Facts] ***********************************************************************************************************************************************************

ok: [nfs]

TASK [Install nfs Server] ********************************************************************************************************************************************************

ok: [nfs]

TASK [Configure NFS Server] ******************************************************************************************************************************************************

ok: [nfs]